NVIDIAの高性能GPU「B200」について徹底解説!スペック・価格・他製品との比較も

「NVIDIAのB200とは?」「従来のGPUと異なる点は?」と考える方もいるでしょう。生成AIや大規模データ解析のニーズが急速に高まる中、NVIDIAが投入した次世代GPU「B200」が注目を集めています。

驚異的なAI性能を誇るB200は、どのような技術革新をもたらすのか?

本記事ではB200のスペックや価格を徹底解説するとともに、他社製品との比較を通じて詳しく紹介します。

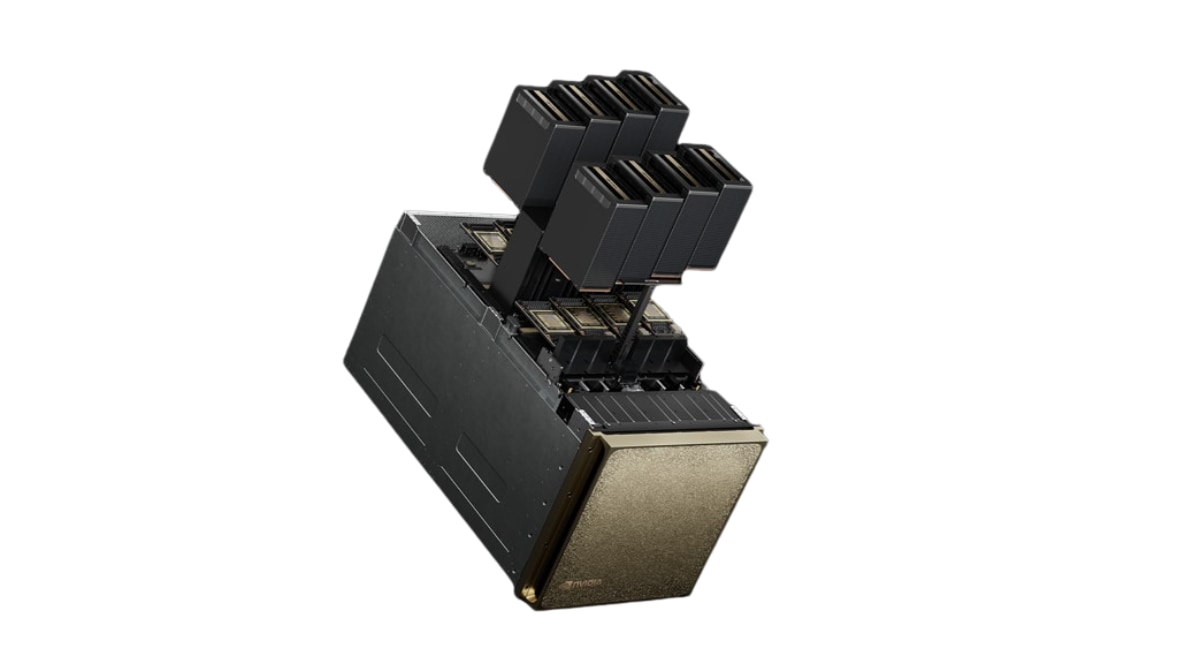

NVIDIAのGPU「B200」とは

(出典:nvidia.com)

NVIDIA B200とは、AI開発やHPC(ハイパフォーマンス・コンピューティング)向けに設計された次世代のGPUです。

前世代のHopperアーキテクチャを上回る性能を実現するために、新たにBlackwellアーキテクチャを採用しました。

B200の半導体チップは、2つのダイを1つのパッケージに統合する特殊な構造を持ち、これからの大規模AIモデルのトレーニングや推論処理を加速させるための中心となる存在になっています。

NVIDIAのGPU「B200」スペック

NVIDIAのGPUについて、Blackwellの「HGX B200」のスペックを紹介します。

以下の表を参照ください。

NVIDIA HGX B200 スペック表

項目 | 仕様 |

|---|---|

アーキテクチャ | |

FP4 Tensor コア | |

FP8/FP6 Tensor コア | |

INT8 Tensor コア | |

FP16/BF16 Tensor コア | |

TF32 Tensor コア | |

メモリ合計 | |

NVLink | |

NVIDIA NVSwitchの特長 | |

NVSwitch GPU から GPU への帯域幅 |

(出典:NVIDIA HGX プラットフォーム|NVIDIA)

NVIDIAのGPU「B200」の価格

NVIDIAはB200 GPU単体の公式な希望小売価格を発表していません。

構築されたサーバーシステムでの販売取り扱いがメインとなっています。

1台あたり約3万ドルから4万ドル(約470万円~630万円、為替レートによる)と推定されています。

主なシステム構成の価格は以下の通りです。

- NVIDIA DGX B200システム

- B200 GPUを8基搭載したサーバーシステムは、約51万5,000ドル(約8,100万円)からの価格設定となっています。

- GB200 Superchip

- Grace CPUとB200 GPU 2基を組み合わせたSuperchipは、約6万ドルから7万ドル(約940万円~1,100万円)と推定されています。

- B200 NVL72 AIサーバー

- フル構成のB200 NVL72 AIサーバーは、約300万ドル(約4億7,000万円)に達することもあります。

(2025年11月時点での情報)

NVIDIAのGPU「B200」は何がすごい?3つの特徴

NVIDIA B200は、前世代のGPUから性能を大幅に引き上げただけでなく、AI開発とデータセンター運用の効率に革新をもたらす複数の特徴を備えています。

以下の3つの点から特徴を詳しく見ていきます。

- AI革命を加速する圧倒的パワー

- 推論もHPCも桁違い

- データセンターの未来を変える効率性

特徴 | 01 |

AI革命を加速する圧倒的パワー

Blackwell GPUは、TSMCの特注4NPプロセスで製造され、2つのダイを10TB/sのチップ間接続で1つのGPUとして統合する革新的な設計を採用しています。

その結果、2080億トランジスタを搭載し、AI処理に不可欠な並列計算能力を極限まで高めました。さらに、Grace CPUと2基のBlackwell GPUを結合した「GB200 Grace Blackwell Superchip」は、NVLink-C2Cによる高速接続を実現し、リアルタイム推論や大規模学習で発生しがちな遅延やボトルネックを解消。

AI開発のスピードとスケーラビリティを劇的に引き上げます。

特徴 | 02 |

推論もHPCも桁違い

B200は、前モデルであるA100やH100/H200の後継として、推論とHPCの両方で飛躍的な性能向上を果たしました。

大規模言語モデルの推論タスクにおいて、H100と比較して最大30倍の性能を発揮し(LLM推論ワークロードに限定)、リアルタイム性が要求されるアプリケーションでの活用が見込まれます。

また、新たにFP4やFP6といったデータ形式をサポートする第2世代TransformerEngineを搭載し、モデルの精度を維持しながら計算効率が大幅に改善されました。

特徴 | 03 |

データセンターの未来を変える効率性

B200は、単体のスペックだけでなく、データセンターの運用効率を改善する点でも注目されています。

高い性能を維持しながらエネルギー効率も追求されており、前世代のHopperアーキテクチャと比較して、GB200 NVL72システム全体で同等の性能を達成するために必要なエネルギーとコストを最大で25分の1にまで削減可能です。

この効率性は、AIファクトリーや大規模データセンターにおけるTCO(総所有コスト)の削減に直接貢献します。

NVIDIAのGPU「B200」を他製品と比較

前世代の「H200」と性能を比較してみます。現在明らかになっている情報を元に、以下の比較表を作成しました。

項目 | HGX B200 | HGX H200(8-GPU 構成) |

|---|---|---|

フォームファクタ | 8 × NVIDIA Blackwell SXM | 8 × NVIDIA H200 SXM |

FP4 Tensor Core(スパース時) | 72 PFLOPS | ― |

FP8 / FP6 Tensor Core(スパース時) | 72 PFLOPS | 32 PFLOPS |

INT8 Tensor Core(スパース時) | 72 POPS | 32 POPS |

FP16 / BF16 Tensor Core(スパース時) | 36 PFLOPS | 16 PFLOPS |

TF32 Tensor Core(スパース時) | 18 PFLOPS | 8 PFLOPS |

FP32 | 600 TFLOPS | 540 TFLOPS |

FP64 / FP64 Tensor Core | 296 TFLOPS | 270 TFLOPS / 540 TFLOPS |

合計メモリ | 1.4 TB | 1.1TB HBM3e |

NVLink | 第5世代 | 第4世代 |

NVIDIA NVSwitch | NVLink 5 Switch | NVLink 4 スイッチ |

NVSwitch GPU間帯域幅 | 1.8 TB/s | 900GB/秒 |

合計 NVLink 帯域幅 | 14.4 TB/s | 7.2 TB/s |

GPU 集約帯域幅 | ― | 38 GB/s |

Attention Performance | 1× | ― |

(出典:NVIDIA HGX プラットフォーム|NVIDIA)

B200はH200と比べてGPUダイの統合やトランジスタ数・メモリ帯域幅の大幅な拡張によって処理効率が飛躍的に高まり、特に次世代LLMの学習や推論において圧倒的なパフォーマンスを発揮できるよう設計されています。

NVIDIAのGPU「B200」のおすすめ活用シーン

次世代アーキテクチャBlackwellを採用したNVIDIA B200は、圧倒的なメモリ帯域と最新のTransformer最適化により、これまでボトルネックだった大規模計算を一気に解放します。

以下は主な活用シーンです。

- 大規模AIモデルのトレーニング

- 自然言語処理と生成AI

- 自動運転やロボティクスなどの自律システムの推論

①大規模AIモデルのトレーニング

大規模AIモデルのトレーニングには、膨大な計算リソースとGPU間の高速通信が必須です。

B200を多数搭載したシステム、特にGB200NVL72は、この要求を満たすために設計されました。

第5世代NVLinkとNVLinkSwitchにより、最大576基のGPUを単一のGPUとして連携させることができ、数兆パラメータ規模のモデルを効率的に学習させます。

この能力により、従来は数ヶ月かかっていたトレーニング期間を数週間にまで短縮することが可能になります。

②自然言語処理と生成AI

自然言語処理(NLP)や生成AIの領域では、より巨大で複雑なモデルが求められており、B200の性能がその進化を強力に後押しします。

B200を搭載したサーバーは、FP4やFP6といった新しいデータ形式に対応することで、推論時のスループットを大幅に向上させます。これにより、チャットボットやコンテンツ生成AIなどのアプリケーションで、より高速かつ自然な応答が実現します。

③自動運転やロボティクスなどの自律システムの推論

自動運転やロボティクスといった自律システムでは、センサーから入力される膨大な情報をリアルタイムで処理し、瞬時に判断を下すための高度な推論能力が不可欠です。

B200の優れた推論性能は、これらのエッジコンピューティング環境の基盤としても重要な役割を果たします。

特に、72基のB200GPUを搭載するGB200NVL72のような高密度システムは、データセンター側で自律システムのシミュレーションやモデル開発を加速させます。

「B200」の後継GPU「B300」とは

「B300」は、Blackwellアーキテクチャの性能をさらに引き上げた強化版「Blackwell Ultra」の正式な製品名です。

完全に新しいアーキテクチャではなく、B200をベースに性能を向上させたモデルとして公式に発表されています。

NVIDIA B300 vs B200 比較スペック表

項目 | HGX B200 | HGX B300 |

|---|---|---|

リリース時期 | ||

FP4 Tensor Core(スパース時) | ||

FP8/FP6 Tensor Core(スパース時) | ||

INT8 Tensor Core(スパース時) | ||

FP16/BF16 Tensor Core(スパース時) | ||

合計メモリ | ||

NVLink | ||

NVSwitch GPU間帯域幅 |

(出典:NVIDIA HGX プラットフォーム|NVIDIA)

B300は2025年後半のリリース予定で、より大規模なAIモデルの訓練や推論に対応できる次世代モデルとして期待されています。

B200を安価に利用するなら「HIGHRESO」

B200は単なるGPUの進化版ではなく、AI時代を牽引する新たなインフラ基盤として位置づけられる存在です。

Blackwellアーキテクチャによる革新的な設計、圧倒的なメモリ帯域幅、そしてFP4/FP6をはじめとする柔軟なデータ形式への対応によって、大規模AIモデルの学習・推論速度を飛躍的に高めるだけでなく、データセンターの効率化やTCO削減にも直結。

後継となるB300の登場も控えており、今後の数年間はB200を軸としたGPU進化の波が、生成AI、HPC、自動運転、ロボティクスなど幅広い分野で新たな可能性を切り開いていくと期待されます。

NVIDIA B200を搭載したGPUクラスターが、1分から使える!

GPU1枚・1分単位で利用でき、面倒な構築作業なしですぐに利用開始できます。B200はH100やH200を上回る性能を備え、生成AI・LLM学習・シミュレーションなど大規模計算に最適。オンプレミスや他社クラウドと比べても圧倒的に低コストで、最新GPUを手軽に利用できます。