プリインストールの利用方法(PyTorch、TensorFlow、JupyterLab)| GPUSOROBAN

本記事では、GPUSOROBAN(高速コンピューティング)のプリインストールの利用方法を説明します。

高速コンピューティングは、画像生成AIやLLMの計算に最適なGPUインスタンスが低コストで使えるクラウドサービスです。

サービスについて詳しく知りたい方は、GPUSOROBANの公式サイトをご覧ください。

初めてGPUSOROBANを利用される場合は、事前に以下の記事をご覧ください。

目次[非表示]

プリインストールとは

高速コンピューティングでは、ソフトウェアがプリインストールされたインスタンスを選択することができ、環境構築の手間を削減することができます。

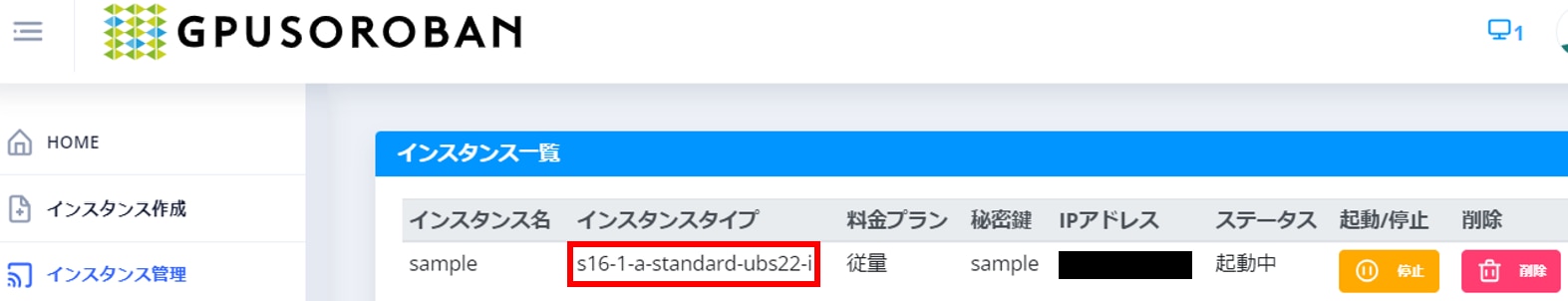

インスタンスの末尾の記号がプリインストールされているソフトウェアを示しています。

次の表はプリインストールのバージョン一覧になります。

インスタンス 末尾の記号 | NVIDIA ドライバ | CUDA | Python | Docker | Tensor Flow | PyTorch | Jupyter Lab |

a | 455 | 10.1 | 3.6 | - | - | - | - |

b | 515 | 11.2 | 3.8 | - | - | - | - |

c | 515 | 11.2 | 3.8 | - | 2.6 | 1.8 | 4.0 |

d | 515 | 11.3 | 3.8 | - | - | - | - |

e | 515 | 11.3 | 3.8 | - | 2.6 | 1.1 | 4.0 |

f | 515 | 11.3 | 3.8 | - | - | - | - |

g | 515 | 11.3 | 3.8 | - | 2.10 | 1.1 | 4.0 |

h | 515 | 11.7 | 3.10 | - | - | - | - |

i | 515 | 11.7 | 3.10 | - | 2.11 | 1.1 | 4.0 |

o | 515 | - | 3.10 | 24.0 | - | - | - |

インスタンスタイプは、コントロールパネルのインスタンス管理から確認できます。

インスタンスのリストはインスタンス一覧のページをご参照ください。

NVIDIAドライバ、CUDA、Pythonの利用方法

インスタンスにはNVIDIAドライバ、CUDA、Pythonが共通でインストールされています。(※Docker対応インスタンスは除く)

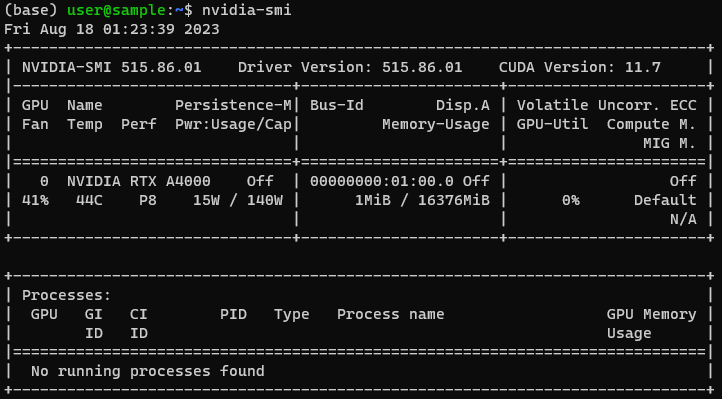

NVIDIAドライバのバージョンは、インスタンスに接続後、次のコマンドで確認ができます。

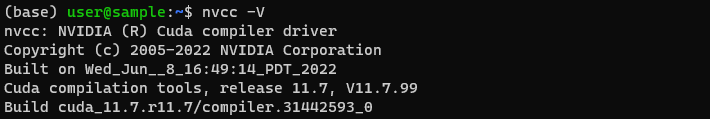

CUDAは次のコマンドで確認ができます。

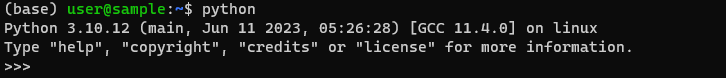

Pythonは次のコマンドで実行できます。

TensorFlow、PyTorch、JupyterLabの利用方法

TensorFlow、PyTorch、JupyterLabを使用する場合は、venv環境をアクティベートする必要があります。

TensorFlow、PyTorchは、プリインストールされているバージョンによって、venv環境をアクティベートするコマンドが異なりますので、ご注意ください。

一方でJupyterLabのvenv環境のアクティベートコマンドはどのインスタンスも共通です。

JupyterLabの利用方法

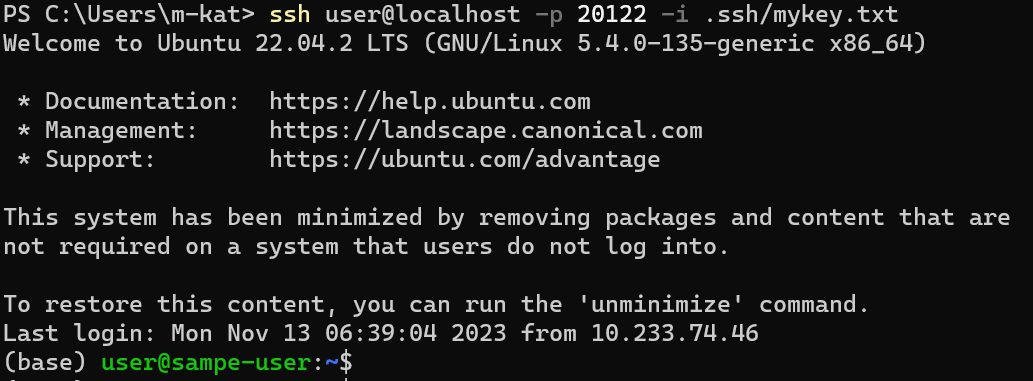

JupyterLabを使用する際は、ポートフォワードの設定をする必要があるため、一度インスタンスに接続しているターミナルからログアウトします。 ※アクセスサーバに接続しているターミナルはログアウトする必要はありません。

インスタンスに接続するターミナルにおいて、次のコマンドを実行します。(ポート8888のポートフォワード)

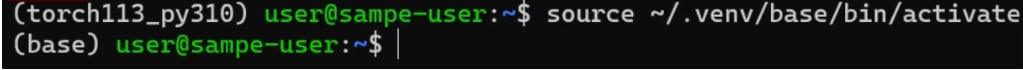

インスタンス接続の際、デフォルトで(base)のvenv環境ログインしています。この(base)にJupyterLabがプリインストールされているため、基本的にアクティベートは不要です。

もしログインしているvenv環境が(base)でない場合、次のコマンドで(base)に切り替えることができます。

※JupyterLabの場合、どのインスタンスタイプにおいても、同じコマンドでvenv環境のアクティベートが可能です。

(base)に切り替わったら、アクティベート完了です。

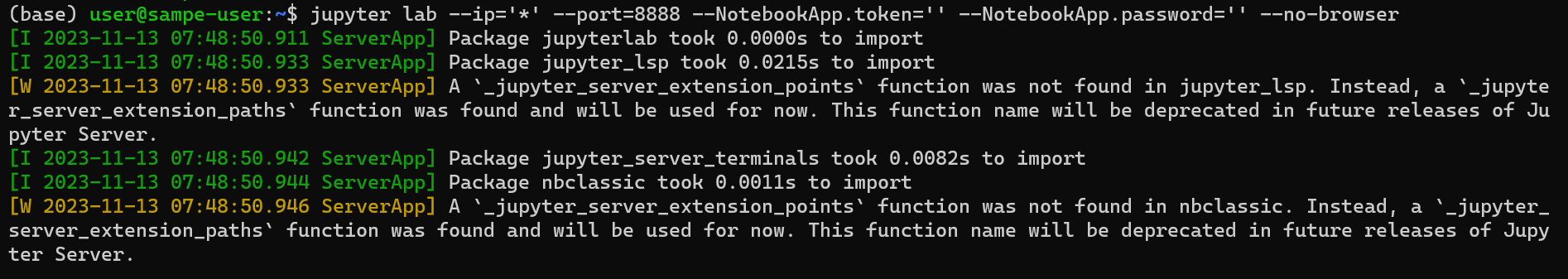

アクティベートした状態で、次のコマンドを実行し、JupyterLabを起動します。

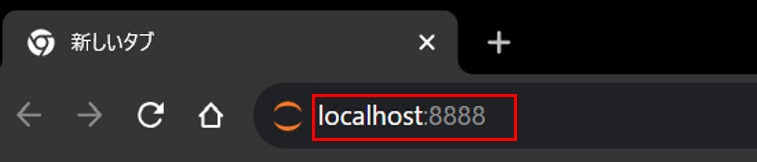

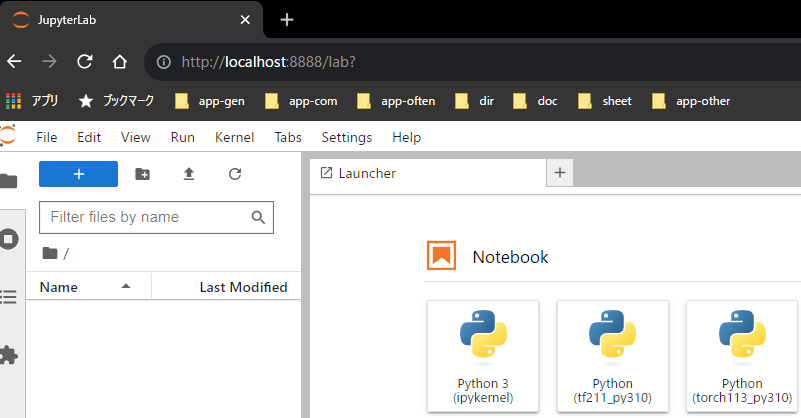

次に接続元PCからブラウザを開き、ブラウザの検索窓にlocalhost:8888を入力し、Enterを押すと、ブラウザにJupyterLabが表示されます。

JupyterLabのUI上で、TensorFlowやJupyterLabのvenv環境を選択することができます。

TensorFlowの利用方法

TensorFlowのvenv環境をアクティベートします。

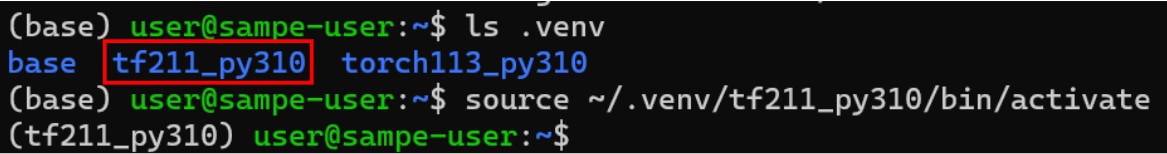

次のコマンドを使用して、.venv環境にプリインストールされているTensorFlowのバージョンを確認した後に、アクティベートコマンドを実行します。

(tf***_py***)に切り替わったら、アクティベート完了です。

※プリインストールしているバージョンによってtf***_py***の値が異なりますので、ご注意ください。

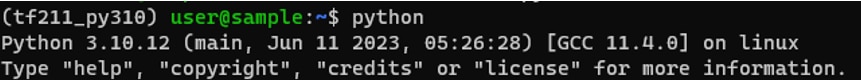

アクティベートした状態で次のコマンドを続けて実行します。

Pythonを実行します。

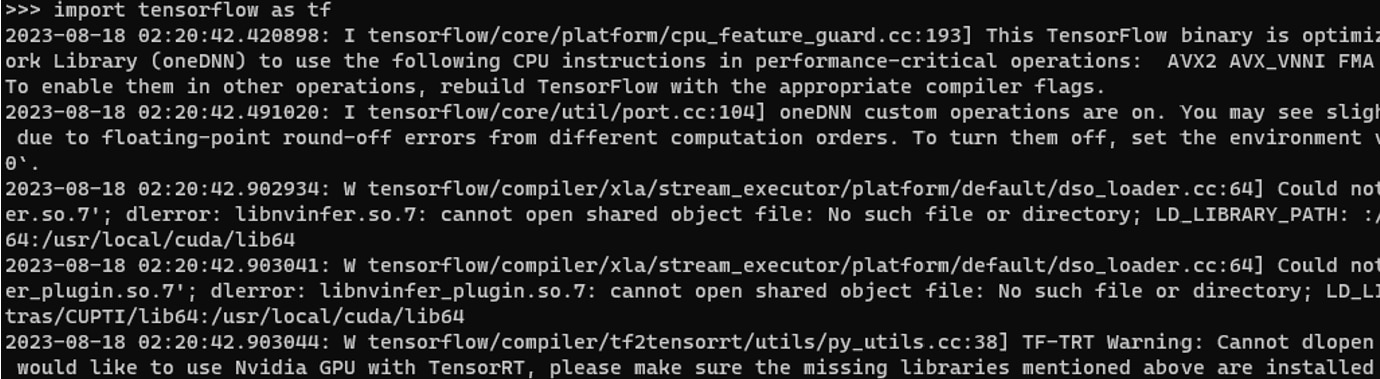

TensorFlowをインポートします。

TensorFlowのバージョンを確認します。

![]()

TensorFlowのバージョンは、2.11.0がインストールされていることが分かります。

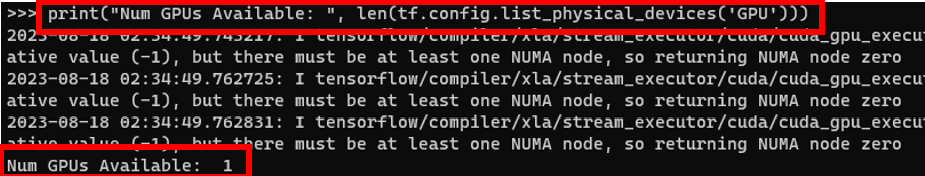

TensorFlowからGPUを確認します。

Num GPUs Available: 1が表示された場合、TensorFlowからGPUが適切に認識できています。

PyTorchの利用方法

PyTorchのvenv環境をアクティベートします。

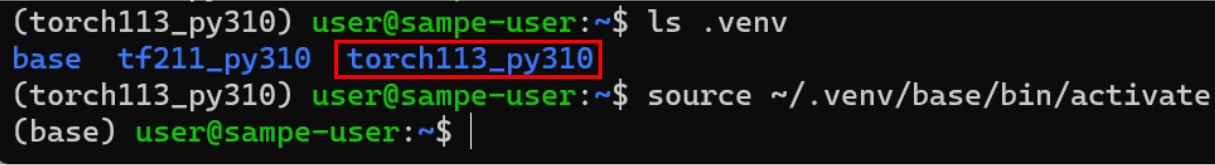

次のコマンドを使用して、.venv環境にプリインストールされているTensorFlowのバージョンを確認した後に、アクティベートコマンドを実行します。

(torch***_py***)に切り替わったら、アクティベート完了です。

※プリインストールしているバージョンによってtorch***_py***の値が異なりますので、ご注意ください。

アクティベートした状態で次のコマンドを続けて実行します。

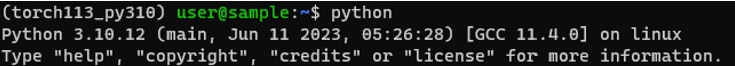

Pythonを実行します。

PyTorchをインポートします。

![]()

PyTorchのバージョンを確認します。

![]()

PyTorchからGPUを確認します。

![]()

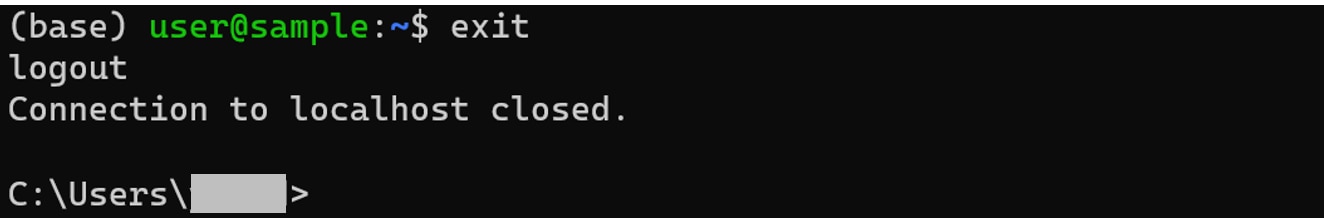

venv環境から抜ける場合

venv環境から抜ける場合は、ターミナルで次のコマンドを実行します。

![]()

(base)の表示が消えて、venv環境から抜けていることが分かります。

ここまでがGPUSOROBAN(高速コンピューティング)のプリインストールの利用方法の説明になります。

高速コンピューティングは高性能なGPUインスタンスが低コストで使えるクラウドサービスです。

サービスについて詳しく知りたい方は、GPUSOROBAN(高速コンピューティング)の公式サイトをご覧ください。