おすすめのAI開発ツール20選一覧。AI開発を効率的にできる方法まで解説

「AIの開発はどのツールを選ぶべき?」「効率的に開発できるツールが知りたい」という方も多いでしょう。

AI開発は、単に高性能なツールを導入すれば成功するものではなく、目的や開発フェーズ、チーム体制に合ったツール選定と、開発プロセス全体を効率化する考え方が必要です。

そこで本記事では、

- おすすめのAI開発ツール20選

- AI開発の種類

- AI開発の選び方

までわかりやすく解説します。また、ツールを「導入して終わり」にしないために、AI開発を効率的に進めるための具体的なポイントや考え方までわかりやすく解説します。

「自社で効率よくAI開発に取り組みたい」という方は、開発するパソコンのスペックも必要になります。仮にスペックが低いと、開発が思うように進まないケースも。そこでおすすめなのが「GPUSOROBAN」が提供するGPUクラウドです。

GPUSOROBANが提供する「NVIDIA H200」は、AI開発に欠かせない大容量メモリを搭載。設備投資も不要なので、業界最安級の価格で使用が可能です。以下のリンクからはNVIDIA H200に関する資料を30秒でダウンロードできますので、ぜひご覧ください。

👉 [資料ダウンロードはこちらから]

AI開発ツールとは?

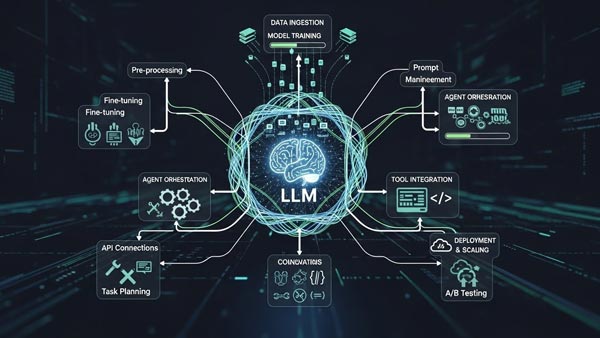

AI開発ツールとは、AIモデルの構築、学習、デプロイ、管理といった一連のプロセスを支援し、効率化するためのソフトウェアやプラットフォームの総称を指します。

これらのツールは、

- データの前処理

- アルゴリズムの選択

- モデルのトレーニング

- 性能評価

などの複雑な作業を自動化・簡略化する機能を提供します。

プログラミングの知識がなくても利用できるものから、専門家向けの高度なカスタマイズが可能なものまで多岐にわたります。

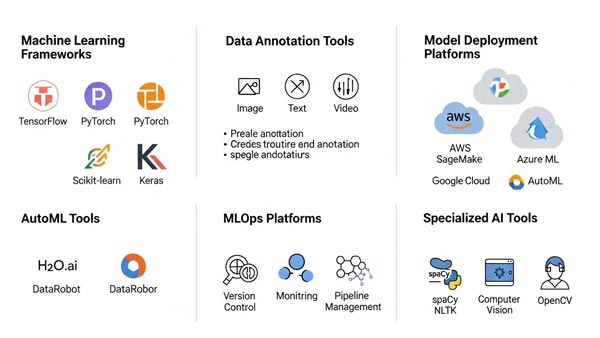

AI開発ツールの種類

AI開発ツールにもツールによって得意な領域・用途は異なります。ここでは大きく4つに分類して、それぞれ特徴を解説します。

- クラウド型AIプラットフォーム

- オープンソースAIフレームワーク

- ノーコード・ローコードAIツール

- 特化型AIツール

AI開発ツール | 01 |

クラウド型AIプラットフォーム

クラウド型AIプラットフォームとは、GoogleCloud、AWS、MicrosoftAzureなどの大手クラウドベンダーが提供する、AI開発に必要な環境を統合的に利用できるサービスを指します。

高性能なGPUサーバーやストレージ、データ分析基盤、機械学習モデルの構築・運用(MLOps)ツールなどが一通り揃っており、インフラの構築や管理の手間なく、すぐに開発を始められます。

利用した分だけ料金が発生する従量課金制が一般的で、初期投資を抑えつつ、必要に応じてリソースを柔軟に拡張できるスケーラビリティがメリットです。

AI開発ツール | 02 |

オープンソースAIフレームワーク

オープンソースAIフレームワークとは、ソースコードが公開されており、無償で利用・改変が可能なライブラリやツール群を指します。

代表的なものにGoogleが開発したTensorFlowや、Metaが主導するPyTorchがあり、世界中の開発者による活発なコミュニティによって支えられています。メリットは、ライセンス費用がかからず、自社の要件に合わせて自由にカスタマイズできる柔軟性の高さです。

最新の研究成果が迅速に反映されることも多く、最先端のAI開発に取り組むことができます。

AI開発ツール | 03 |

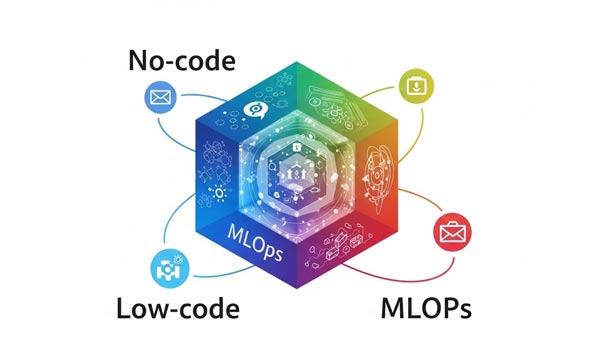

ノーコード・ローコードAIツール

ノーコード・ローコードAIツールとは、プログラミングの知識がほとんど、あるいは全くなくても、GUIを通じて直感的な操作でAIを開発できるツールを指します。

画面上のコンポーネントをドラッグ&ドロップで組み合わせるだけで、データ分析や予測モデルの構築が可能です。エンジニアだけでなく、業務知識を持つ現場の担当者が主体となってAI活用を進められます。

開発期間を短縮し、迅速なプロトタイピングを実現できる点が利点です。近年では、Youtubeの動画分析や字幕生成など、特定の用途に特化したサービスも数多く登場しています。

AI開発ツール | 04 |

特化型AIツール

特化型AIツールとは、画像認識、自然言語処理、需要予測、異常検知といった特定の業界や業務課題の解決に特化して設計されたツールを指します。

汎用的なプラットフォームとは異なり、解決したい課題が明確な場合に高い効果を発揮します。

専門知識がなくても導入・運用しやすいようにパッケージ化されている製品が多く、システムエンジニア以外のビジネス担当者でも比較的容易に利用を開始できます。

導入してすぐに業務価値を生み出しやすいため、特定の課題を迅速に解決したい場合に有効な選択肢です。

失敗しないAI開発ツールの選び方

AI開発ツールの選定は、プロジェクトの成否を左右する重要なプロセスです。多種多様なツールの中から自社に最適なものを見つけるためには、いくつかの重要な視点を持つ必要があります。

ここでは、ツール選定時に必ず確認すべき4つのポイントを具体的に解説します。

- 開発リソースと合うか確認する

- 既存の開発フローと統合できるか

- セキュリティ要件を満たしているか

- 非エンジニアでも使えるか

失敗しない選び方 | 01 |

開発リソースと合うか確認する

AI開発ツールを選定する際は、まず自社の開発チームのスキルセットや規模といったリソース状況を正確に把握することが不可欠です。

Pythonや主要なAIフレームワークに精通したエンジニアが豊富に在籍している場合、カスタマイズ性の高いオープンソースフレームワークが能力を最大限に活かせます。

一方で、AI専門の人材が限られている、あるいはビジネス部門が主導で開発を進めたい場合は、専門的なプログラミング知識を必要としないノーコード・ローコードツールや、手厚い技術サポートが受けられるクラウドプラットフォームが適しています。

失敗しない選び方 | 02 |

既存の開発フローと統合できるか

新たに導入するAI開発ツールが、既存のシステムや開発ワークフローとスムーズに連携できるかは、生産性を左右する重要なポイントです。

現在使用しているデータ基盤、バージョン管理システム、CI/CDパイプラインといった環境との親和性を事前に確認する必要があります。

ツールが提供するAPIの仕様や、対応しているデータフォーマット、連携可能な外部サービスなどを調査し、導入によって既存のプロセスが分断されたり、不必要に複雑化したりしないかを見極める必要があります。

失敗しない選び方 | 03 |

セキュリティ要件を満たしているか

AI開発では個人情報や企業の機密情報など、センシティブなデータを取り扱う機会が多く、セキュリティは最も優先すべき要件の一つです。

特にクラウドサービスを利用する場合、そのプラットフォームが自社のセキュリティポリシーや業界の規制基準を遵守しているかを確認しなくてはなりません。

データの暗号化、アクセス制御の仕組み、不正アクセスの監視体制といった基本的な機能に加え、ISO/IEC27001などの国際的なセキュリティ認証を取得しているかも重要な判断基準となります。

ツールの機能性やコストだけでなく、データを安全に保護できる堅牢なセキュリティを備えているかを厳しく評価することが求められます。

失敗しない選び方 | 04 |

非エンジニアでも使えるか

AI活用を全社的に推進するには、エンジニアだけでなくビジネス部門の担当者など、非エンジニアの参加が必須です。そのため、ツールの選定基準として「非エンジニアでも使えるか」という視点が重要になります。

直感的なGUIを備えたノーコード・ローコードツールは、プログラミング経験がないユーザーでもデータ分析や簡単なモデル構築を行えるように設計されています。

現場の課題を最もよく知る担当者が自らAIを活用して業務改善の試行錯誤ができるようになれば、AI導入のスピードと効果はに高まるでしょう。

種類別|おすすめのAI開発ツール20選一覧表

まずは、おすすめのAI開発ツールを20個紹介します。

ツールの種別と用途を確認して、適切なツールを選択しましょう。

|

ツール名 |

種類 | 主な用途 | 主な機能・特徴 |

| IBM watsonx | クラウド型AIプラットフォーム |

生成AI/機械学習 |

基盤モデル+ML統合、データ基盤、AIガバナンス |

| Bedrock/SageMaker | 生成AI/ML/MLOps | 複数LLM API、学習〜デプロイ一体 | |

| Azure AI/OpenAI | 生成AI/RAG/検索 | GPT系LLMとRAG設計、MLOps | |

| Vertex AI | 生成AI/ML/MLOps | Gemini系モデル、MLOps一気通貫 | |

| OCI Generative AI/Data Science | 生成AI/ML | Oracle DB・ERP連携に強い | |

| TensorFlow |

OSSフレームワーク |

ディープラーニング | Keras/TensorBoard/TFX等エコシステム |

| PyTorch | 深層学習研究開発 | 動的計算グラフ、TorchServe等 | |

| scikit‑learn | 機械学習全般 | 分類・回帰・前処理・評価 | |

| Transformers | NLP/音声/画像 | 多数の学習済みモデル+Pipelines | |

| Keras | DLプロトタイピング | 高レベルAPI、多バックエンド | |

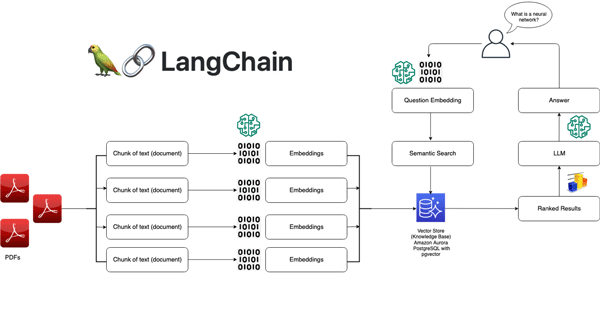

| LangChain |

LLM/エージェント開発フレームワーク |

LLMアプリ/エージェント | モジュラーなチェーン・エージェント抽象化と外部ツール統合 |

| LlamaIndex | RAG/データ接続 | LLMと社内データを結ぶ索引・パイプライン | |

| Haystack | RAG/検索 | RAGパイプライン・検索アプリ構築 | |

| Rasa | 会話AI | NLU・ダイアログ管理を備えたチャットボット開発 | |

| Diffusers | 画像生成 | 拡散モデルライブラリ、Stable Diffusion等 | |

| Dify.ai | ノーコード/ローコード・MLOps |

ノーコードLLMアプリ | ドラッグ&ドロップのAIワークフロー、RAG・エージェント構築 |

| Streamlit | データ・AIアプリ | 短いPythonコードでインタラクティブアプリ作成 | |

| DataRobot | AutoML/MLOps | モデル作成〜特徴量設計・デプロイ・監視まで自動化 | |

| MLflow | MLOps | MLライフサイクル管理、実験追跡・デプロイ | |

| W&B | 実験追跡/MLOps | 実験管理・データセットバージョン管理・可視化 |

クラウド型AIプラットフォーム

クラウド型AIプラットフォームとは、開発から準備~開発完了までの工程を、一つのサービス上で、シームレスに実行できる「統合開発環境」の事を指します。

IBM watsonx

(出典:ibm.com)

IBM watsonxは、企業向けAI開発を一つの環境で完結できる統合型クラウドプラットフォームです。

主に以下の3つで構成されています。

- watsonx.ai:AIモデルや生成AIを開発・検証するスタジオ

- watsonx.data:クラウドとオンプレミスをまたいだデータ管理基盤

- watsonx.governance:AIの利用ルールやコンプライアンスを管理

IBM独自のモデルに加え、Hugging Faceのオープンソースモデルも利用でき、ノーコードから本格的なコーディング開発まで対応します。

RAGや要約、質問応答などのNLP機能も標準搭載されており、金融・通信・公共分野など、厳しい規制がある業界に向いている点が特徴です。

Bedrock/SageMaker

(出典:aws.amazon.com)

Amazon Bedrockは、インフラ管理が不要な生成AI基盤です。

Claude、Llama、Cohereなど複数のAIモデルを共通APIで簡単に切り替えて利用でき、試作から本番までを短期間で進められます。

- サーバーレスで即利用可能

- AWSサービスと自動連携

- 使った分だけ支払う従量課金

そのため、スタートアップや新規事業の高速検証に向いています。一方のSageMakerは、より高度な機械学習開発向けの基盤です。

データ処理から学習、デプロイ、運用(MLOps)までを一貫して管理でき、需要予測や不正検知など本格的なML活用を行う大企業向けに設計されています。

Azure AI/OpenAI

(出典:microsoft.com)

Azure OpenAI Serviceは、OpenAIの最新モデルを企業向けに安全に使えるプラットフォームです。GPT系モデルや画像生成、音声認識などを、Microsoftのクラウド基盤上で利用できます。

特徴は以下の通りです。

- 厳格なアクセス管理と高いセキュリティ

- 医療・金融・公共分野向けのコンプライアンス対応

- Microsoft 365 や Power Platform との強力な連携

すでにMicrosoft製品を多く使っている企業にとって、既存環境を活かした生成AI導入がしやすい点が大きなメリットです。

Vertex AI

(出典:cloud.google.com)

Google Vertex AIは、AI開発から運用までを一元管理できるMLOps基盤です。データ準備、モデル学習、評価、デプロイ、監視までを一つの環境で行えます。

また、「AutoMLによる簡単なモデル作成」「TensorFlow・PyTorchなどによる高度なカスタム開発」「Geminiを含む多数のAIモデルに対応」などさまざまな特徴を持っています。

データ分析から生成AIまでを本格的に活用したい企業に適したプラットフォームです。

OCI Generative AI/Data Science

(出典:oracle.com)

OCI Generative AIは、Oracle製品を利用している企業向けに最適化されたAI基盤です。Oracle DatabaseやERPとスムーズに連携できる点が最大の強みです。

- 企業専用環境での安全な生成AI利用

- 少ないデータで効率よく調整できるファインチューニング

- 多言語対応・AIエージェント管理機能

加えて、OCI Data ScienceではJupyterLabやMLOps機能も利用でき、既存のOracle IT環境に生成AIを組み込みたい企業に向いています。

OSSフレームワーク

「オープンソースのAIフレームワーク」とは、誰もが無料で利用できる、AI開発の骨組みとなるプログラムの集まりのことです。この骨組みを使えば、AIの複雑な処理を一から実装する必要がなくなります。

TensorFlow

(出典:tensorflow.org)

TensorFlowはGoogleが開発した、本番環境での運用を強く意識した深層学習フレームワークです。CPU・GPU・TPUといったさまざまな計算資源を使った大規模な分散学習に対応しており、データ量やモデル規模が大きくなっても安定して処理できる点が特徴です。

TensorFlow 2.0以降は、Pythonのコードをそのまま実行できる「eager execution」が標準になり、初心者でも挙動を確認しながら開発しやすくなりました。さらに、XLAという最適化技術により、大規模モデルでは学習や推論の高速化も期待できます。

PyTorch

(出典:pytorch.org)

PyTorchはMetaが開発した、研究や実験を重視した深層学習フレームワークです。最大の特徴は、コードを実行しながらモデルの構造を自由に変更できる「動的計算グラフ」で、Pythonを書いている感覚に近い形でモデルを作れる点にあります。

if文やfor文など通常のPython制御構文をそのまま使えるため、複雑なモデル構造や新しいアイデアの検証がしやすく、デバッグもしやすいのが強みです。そのため、研究論文の実装やプロトタイプ開発では事実上の標準になっています。

scikit‑learn

(出典:scikit-learn.org)

scikit-learnは、表形式データを扱う機械学習に特化したPythonライブラリです。分類・回帰・クラスタリングなどの代表的なアルゴリズムを、ほぼ同じ書き方で利用できるため、機械学習の入門として非常に人気があります。

モデル学習は fit()、予測は predict() という統一されたAPIで扱えるため、アルゴリズムを切り替えてもコードの変更が最小限で済みます。また、前処理から学習までをまとめられるPipelineや、パラメータ調整を自動化するGridSearchなど、実務で役立つ機能も揃っています。

Transformers

(出典:huggingface.co)

Transformersは、自然言語処理や生成AI開発の中心的存在となっているライブラリで、BERTやGPTなどの学習済みモデルを数行のコードで利用できる点が

特徴です。モデルはHugging FaceのModel Hubで公開されており、誰でも簡単に試せます。

文章分類、要約、質問応答、文章生成などの処理を「Pipeline」という仕組みで簡単に実装でき、専門知識が少なくても高度なNLP機能を使えるのが強みです。また、学習・評価・分散処理をまとめて管理できるTrainer APIも用意されています。

Keras

(出典:cloud.google.com)

Kerasは、深層学習を分かりやすく、少ないコードで書くための高レベルAPIです。もともとは独立したライブラリでしたが、現在はTensorFlow公式のインターフェースとして統合されています。

Sequential APIを使えば層を順番に並べるだけでモデルを構築でき、Functional APIを使えば複雑なネットワーク構造にも対応できます。学習や評価も compile() と fit() を使うだけなので、初心者でも全体の流れを理解しやすい設計です。

LLM/エージェント開発フレームワーク

LLM/エージェント開発フレームワークは文字通り、AI開発においてフレームワークを活用したツールです。

LangChain

(出典:langchain.com)

LangChainは、LLMを使ったアプリケーション開発を効率化するための統合フレームワークで、OpenAIやAnthropicなど複数のLLMを共通の書き方で扱える点が特徴です。

複数の処理をつなぐ「Chains」により、プロンプト生成から回答整形までを一連の流れとして設計でき、AgentsとToolsを組み合わせることで、APIやデータベースを呼び出しながらタスクを自律的に実行するAIエージェントを構築できます。

さらにMemoryで会話履歴を保持し、Retrieversを使ってRAG構成も実装できるため、複雑な業務フローを持つLLMアプリやエージェント開発に最適な基盤です。

LlamaIndex

(出典:llamaindex.ai)

LlamaIndexは、社内文書やPDF、データベースなどの既存データをLLMが扱いやすい形に整理・検索できるようにするデータ特化型フレームワークです。

多様なデータソースを読み込み、用途に応じたインデックスを作成することで、意味を理解したセマンティック検索を実現し、単なる全文検索より高精度な情報取得が可能になります。

特にRAG構成に強く、LLMに「社内ナレッジを正確に参照させたい」場合に有効で、比較的シンプルな構成で実務向け検索・QAシステムを作れる点が強みです。

Haystack

(出典:haystack.deepset.ai)

Haystackは、検索・質問応答・生成AIを統合したエンタープライズ向けフレームワークで、本番運用を前提とした堅牢な設計が特徴です。

Retriever・Reader・Generatorといった処理ノードをPipelineとして組み合わせることで、検索から回答生成までを明確に制御でき、YAML定義にも対応するため運用・保守性が高くなります。

ドキュメント管理や評価機能も充実しており、高精度なRAGや業務向けQAシステムを安定して運用したい企業向けの選択肢といえます。

Rasa

(出典:rasa.com)

Rasaは、チャットボットや音声アシスタントなどの対話型AIを構築するためのオープンソースフレームワークで、クラウド依存せずオンプレミス環境でも利用できる点が大きな特徴です。

Rasa NLUでユーザーの発話意図や情報を抽出し、Rasa Coreで会話の流れを制御することで、業務に即した対話ロジックを細かく設計できます。

近年はLLMを活用した自然な対話にも対応しており、データ主権やセキュリティを重視する企業の社内問い合わせ対応などに適したツールです。

Diffusers

(出典:huggingface.co)

Diffusersは、Hugging Faceが提供する拡散モデル専用のPythonライブラリで、Stable Diffusionをはじめとした画像生成モデルをプログラムから直接制御できます。

GUI操作ではなくコードベースで生成処理を管理できるため、大量の画像生成やパラメータ制御、モデル切り替えを自動化しやすいのが特徴です。

LLMとは異なる生成AI分野を担うツールで、画像生成を組み込んだアプリやデータセット生成、デザイン補助用途に最適なフレームワークです。

ノーコード/ローコード・MLOps

AI開発はプログラミングの知識がなくてもAI開発が可能です。特に初心者に使いやすい5つのツールを紹介します。

Dify.ai

(出典:Dify.ai)

Difyは、プログラミング知識がなくてもLLMを使ったAIアプリを構築できるノーコード開発プラットフォームで、画面上でノードをドラッグ&ドロップするだけで検索・要約・翻訳・生成といった複数ステップの処理を組み立てられます。

RAG機能によりPDFやCSVなどの社内データをナレッジとして登録し、質問に応じて自動検索・参照しながら回答を生成できるため、社内FAQやサポートボットの構築が容易です。

さらにマルチモーダル対応により画像や音声も扱えるため、ビジネス部門主導でAI活用を進めたい企業に適したツールです。

Streamlit

(出典:streamlit.io)

Streamlitは、Pythonコードだけで対話型のWebアプリを構築できるローコードフレームワークで、HTMLやJavaScriptを意識せずにグラフ、表、入力フォームなどを数行で作成できます。

ユーザー操作に応じてリアルタイムに結果が更新されるため、分析結果やAI推論の挙動をその場で確認でき、データサイエンティストが自分で可視化ツールを作れる点が特徴です。

GitHub連携による簡単デプロイも可能で、分析結果を素早く共有・検証したいプロジェクトに向いています。

DataRobot

(出典:datarobot.com)

DataRobotは、データを投入するだけで最適な機械学習モデルを自動構築・評価・運用まで行うAutoMLプラットフォームで、専門的なデータサイエンス作業を大幅に自動化します。

欠損値処理や特徴量生成、モデル選定が自動で実行され、さらに「なぜその予測になったのか」を説明する可視化機能により、非技術者にも理解しやすい結果を提供します。

本番環境での精度監視や再学習まで対応しており、予測精度と信頼性が求められる大企業向けのAI基盤です。

MLflow

(出典:mlflow.org)

MLflowは、機械学習の実験・モデル・デプロイを一元管理するオープンソースMLOps基盤で、どの実験がどの条件で行われ、どのモデルが本番に使われているかを明確に管理できます。

実験結果の自動記録、再現可能な実行環境の共有、モデルのバージョン管理や承認フローまでを統合できるため、チーム開発における混乱を防ぎます。

クラウドやKubernetesとも連携しやすく、中〜大規模AIプロジェクトの運用基盤として標準的に使われています。

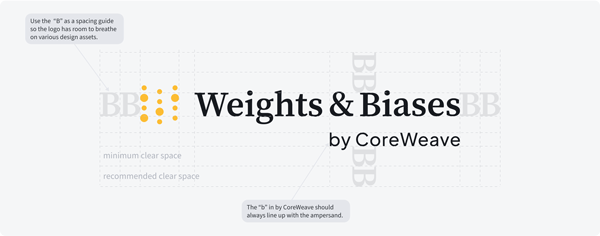

W&B

(出典:wandb.ai)

Weights & Biasesは、機械学習実験の進捗や結果をリアルタイムで可視化・共有できるクラウド型MLOpsツールで、数行のコードを追加するだけで学習状況を自動記録できます。

パラメータ違いの実験を並べて比較でき、精度や損失の変化をグラフで直感的に把握できるため、試行錯誤の効率が大幅に向上します。

GPU使用率などのリソース監視にも対応しており、深層学習を中心とした研究・開発チームに特に適したツールです。

AI開発を効率的にできる3つの方法

ツールを効果的に活用するためには、開発プロセス全体を見直し、ボトルネックとなりがちな部分を解消する工夫が求められます。

ここでは、AI開発のスピードと質を向上させるために重要となる3つの方法を紹介します。

- 高性能GPUを利用する

- 事前学習モデルを活用する

- データの収集・整備は事前に実施しておく

効率化POINT | 01 |

高性能GPUを利用する

AIの学習には、膨大な量の行列演算が必要です。この種の並列計算は、CPUよりもGPU(Graphics Processing Unit)の方が圧倒的に高速に処理できます。

高性能なGPUを利用することで、数週間かかっていたモデルの学習時間を数日、あるいは数時間にまで短縮することが可能です。

これにより、より多くのアイデアを迅速に試し、モデルの改善サイクルを高速化できます。

自社で高価なGPUサーバーを所有・維持管理するのはコストと手間がかかるため、必要な時に必要な分だけリソースを借りられるクラウドGPUサービスを活用するのがおすすめ。GPUSOROBANでは、高性能GPUを業界最安級で提供しています。

以下のリンクからまずは無料で資料のダウンロードして詳細を確認してみてください。

効率化POINT | 02 |

事前学習モデルを活用する

AIの学習には、膨大な量の行列演算が必要です。この種の並列計算は、CPUよりもGPU(Graphics Processing Unit)の方が圧倒的に高速に処理できます。

高性能なGPUを利用することで、数週間かかっていたモデルの学習時間を数日、あるいは数時間にまで短縮することが可能です。

これにより、より多くのアイデアを迅速に試し、モデルの改善サイクルを高速化できます。

自社で高価なGPUサーバーを所有・維持管理するのはコストと手間がかかるため、必要な時に必要な分だけリソースを借りられるクラウドGPUサービスを活用するのがおすすめ。GPUSOROBANでは、高性能GPUを業界最安級で提供しています。

以下のリンクからまずは無料で資料のダウンロードして詳細を確認してみてください。

効率化POINT | 03 |

データの収集・整備は事前に実施しておく

AI開発プロジェクトにおいて、モデルの性能は学習データの質と量に依存します。 質の低いデータを使えば、どれだけ優れたアルゴリズムやツールを用いても良い結果は得られません。

実際、AI開発の時間の大半が、データの収集、欠損値の処理、ラベル付け(アノテーション)といった地道なデータ整備作業に費やされることも少なくありません。 そのため、本格的なモデル開発に着手する前に、プロジェクトの目的に沿ったデータを定義し、十分な量を確保し、品質を高める作業を計画的に進めておくことが極めて重要です。

AI開発効率を最大化する「GPUSOROBAN」

GPUSOROBANは、AI開発にな高性能GPUサーバーを、業界トップクラスの低コストで利用できるクラウドサービスです。

NVIDIA社の最新GPUを搭載したサーバーを、大規模な初期投資なしで、時間単位や月単位で柔軟にレンタルできます。

煩雑な環境構築は不要で、申し込み後すぐに利用を開始できるため、開発者は計算リソースの調達や管理に煩わされることなく、本来のモデル開発に集中できます。

特に、計算コストがボトルネックとなりがちなスタートアップや大学の研究室、個人の開発者にとって、高速な計算環境を手軽に利用できることは、開発サイクルの短縮とイノベーションの加速に直結します。