【Llama2】APIでの使い方 | Replicate API

この記事では、Llama2をWeb API経由で使う方法について解説しています。

目次[非表示]

- 1.Llama2とは

- 2.Llama2をAPIで使う方法(Replicate API)

- 3.一定の制約のもと無料で使える

- 4.実行環境

- 5.GitHubのアカウントを作成する

- 6.Replicateに登録する

- 7.APIトークンを発行する

- 8.モデルを探す

- 9.Jupyter Labの起動

- 10.トークンを入力

- 11.テキスト生成の実行

- 12.出力結果の確認

- 13.LLMならGPUクラウド

- 14.まとめ

Llama2とは

Llama2(Large Language Model Meta AI 2/ラマツー)とは、Facebookを運営するMeta社が開発した言語生成AI(LLM)で、OpenAI社のChatGPTに匹敵するの性能を持っています。

Llama2の特徴としては、軽量モデルで高性能、そして無料で使えるオープンソースであるため、開発者にとって扱いやすいモデルになっています。

Llama2の詳細については、以下の記事で解説しています。

Llama2をAPIで使う方法(Replicate API)

Replicateは、手軽に生成AIモデルを実行できるクラウドプラットフォームです。

このプラットフォーム上で提供される生成AIモデルは、Web APIを通じてアクセス可能です。

APIを利用することで、数行のコードを実装するだけで、簡単にLlama2を実行できます。

一定の制約のもと無料で使える

Replicate APIは一定期間中、一定のトークン数までは無料で利用できます。ただし、一定のトークン数を超える場合は1トークンごとに料金が発生します。

クレジットカードを入力せずに利用できますので、以下のエラーメッセージがでるまでは無料で使うことができます。

実行環境

Replicate APIを使用する際にコードが公開されている実行環境は以下のいずれかになります。

この記事ではPythonを使用しています。

- Node.js

- Python

- Elixir

- HTTP

- Cog

- Docker

GitHubのアカウントを作成する

登録がまだの場合は、GitHubのサイトにアクセスし、[Githubに登録する]からアカウント作成をします。

Replicateに登録する

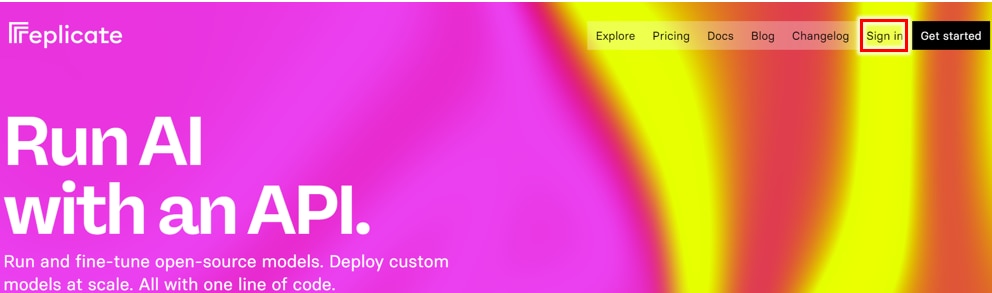

GitHubのアカウントを作成したら、Replicateのサイトにアクセスします。

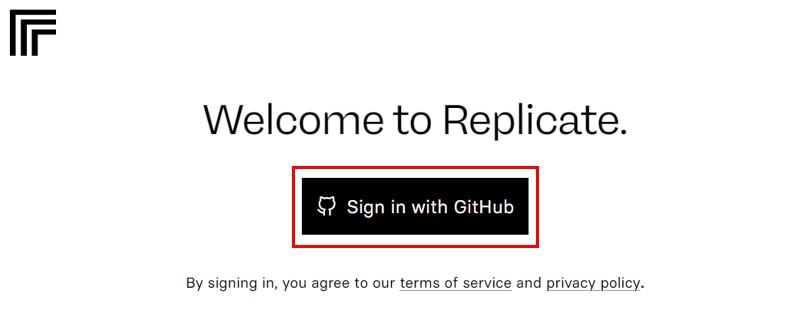

[Get started]ボタンをクリックして、続けて[Sign in with GitHub]ボタンをクリックします。

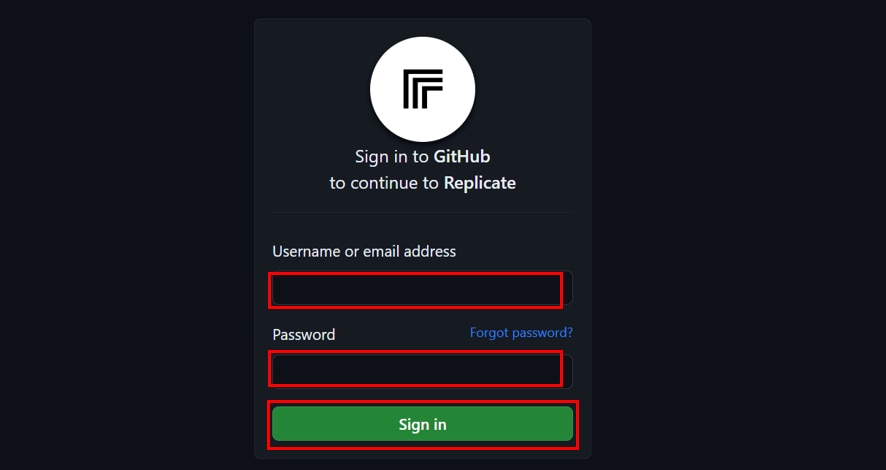

GitHubにサインインするページが表示されますので、GitHubで登録した[Username or email address]と[Password]を入力し、[Sign in]をクリックしてください。

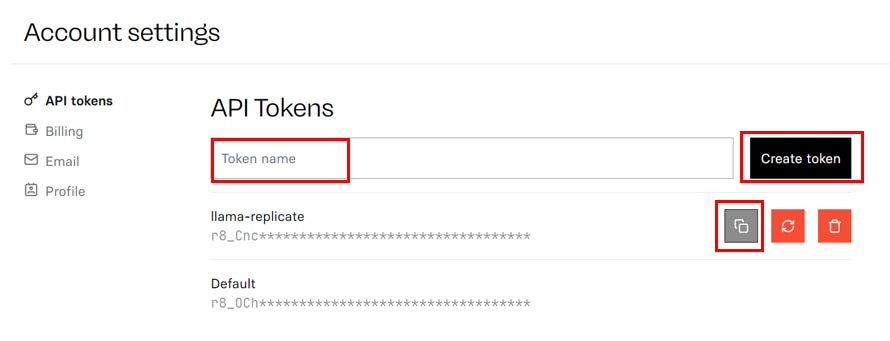

APIトークンを発行する

Replicateにログインが完了したら、[Account setting]のページから、APIトークンを発行します。

[API Tokens]に任意のトークン名を入力し、[Create token]をクリックすると、APIトークンの発行が完了します。

発行したAPIトークンは[コピー]ボタンから、コピーすることができます。

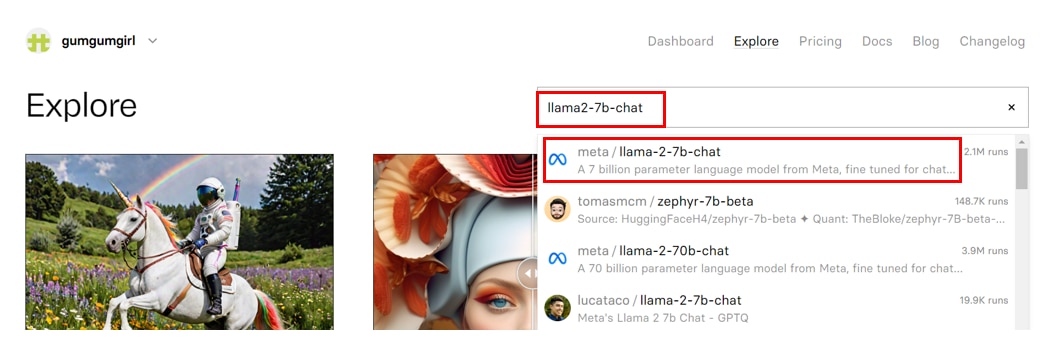

モデルを探す

以下のページからReplicate APIで使用するモデルを検索します。

[検索窓]に以下の表を参考に[model_id]を入力することで検索できます。

model_id |

パラメータ数 |

特徴 |

meta/Llama-2-7b |

70億 |

ベースモデル |

meta/Llama-2-13b |

130億 |

ベースモデル |

meta/Llama-2-70b |

700億 |

ベースモデル |

meta/Llama-2-7b-chat |

70億 |

自然な会話ができるように ベースモデルをファインチューニングしたモデル |

meta/Llama-2-13b-chat |

130億 |

自然な会話ができるように ベースモデルをファインチューニングしたモデル |

meta/Llama-2-70b-chat |

700億 |

自然な会話ができるように ベースモデルをファインチューニングしたモデル |

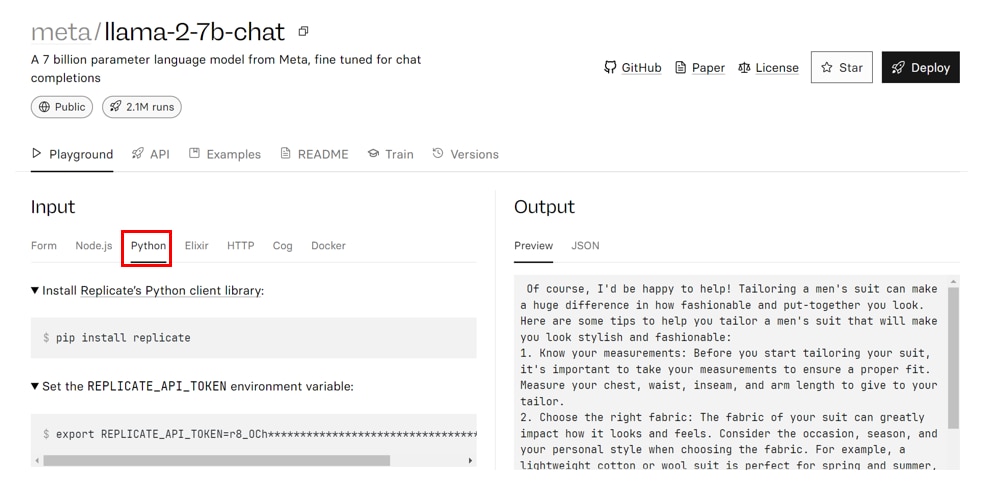

モデルのページが表示されたら、[Python]のタブをクリックします。

そこにPythonでAPIを使用するコードが書かれていますので、コピーして利用できます。

特に[meta/llama-2-7b-chat:xxxx]と書かれているモデルIDを後ほど使いますので、控えておきます。

Jupyter Labの起動

この記事ではJupyter LabのUIでPythonを使用しています。

コードセルで次のコマンドを実行し、必要なライブラリをインストールします。

必要なライブラリをインポートします。

トークンを入力

発行したトークンを次のコマンドに埋め込み、コードセルを実行します。

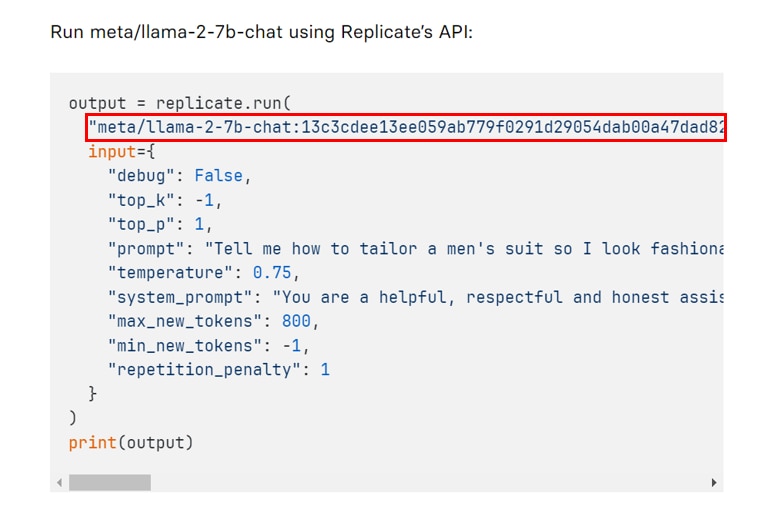

テキスト生成の実行

モデルを指定して、テキスト生成を行います。

["meta/llama-****************"]の部分がmodel_idになりますので、他のモデルを使用する場合は差し替えてください。

["prompt":]にプロンプトを入力します。

出力結果の確認

次のコマンドを実行し、テキストの生成結果を確認します。

出力結果

日本語翻訳

LLMならGPUクラウド

Llama2やその他のLLMを使用する際には、モデルサイズやタスクに応じて必要なスペックが異なります。

LLMで使用されるGPUは高価なため、買い切りのオンプレミスよりも、コストパフォーマンスが高く柔軟な使い方ができるGPUクラウドをおすすめしています。

GPUクラウドのメリットは以下の通りです。

- 必要なときだけ利用して、コストを最小限に抑えられる

- タスクに応じてGPUサーバーを変更できる

- 需要に応じてGPUサーバーを増減できる

- 簡単に環境構築ができ、すぐに開発をスタートできる

- 新しいGPUを利用できるため、陳腐化による買い替えが不要

- GPUサーバーの高電力・熱管理が不要

コスパをお求めなら、メガクラウドと比較して50%以上安いGPUクラウドサービス「GPUSOROBAN」がおすすめです。

大規模なLLMを計算する場合は、NVIDIA H100のクラスタが使える「GPUSOROBAN AIスパコンクラウド」がおすすめです。

まとめ

この記事では、Llama2をWeb API経由で使う方法について紹介しました。

Llama2は無料で使えて商用利用可能な利便性の高いモデルでありながら、ChatGPTと同等以上の性能があります。

Llama2に関する詳細な情報は、以下の記事でまとめて紹介していますので、あわせてご覧ください。