生成AI・機械学習に強いNVIDIA AI GPUおすすめ10選。AMDとの性能を比較

「生成AIや機械学習に最適なNVIDIAのAI GPUはある?」「AMDと何が違う?」と考える方もいるでしょう。NVIDIAのAI GPUは圧倒的な演算性能とCUDAによる開発環境の充実度から、生成AIや機械学習の分野で世界的に高いシェアを誇ります。

一方で、AMD製GPUも価格面や電力効率で優れた製品を提供しており、コスト重視や用途によっては選択肢となり得ます。

そこで本記事では、

- 業界標準のNVIDIA製AI GPUの紹介

- 最新のおすすめモデル10選

- AMD製GPUとの比較

まで詳しく解説します。

生成AIや機械学習に強いAI GPUの導入を検討している方は最後までご覧ください。

「NVIDIAのAI GPUを低価格で導入したい」「お試しで体験したい」という方は、HAIRESOを利用するのがおすすめ。HAIRESOが提供する「AIスパコンクラウド」は、NVIDIA H200を搭載したGPUインスタンスが業界最安級で使えるクラウドサービスです。

以下のリンクから無料で資料ダウンロードもできますので、ぜひチェックしてみてください。

目次[非表示]

- 1.AI開発向けのGPUとは?

- 2.AI用途のGPUはNVIDIAがなぜおすすめなのか

- 3.AI開発で利用するGPUを購入する際の選び方

- 3.1.初期コストと運用コストのバランスを比較する

- 3.2.処理するAIタスクに応じて「コア」の種類を選定する

- 3.3.モデルサイズとGPUメモリ容量の整合性を確認する

- 3.4.熱処理・冷却性能の水準を明確にする

- 4.AI用途におけるNVIDIAとAMDを徹底比較

- 5.【NVIDIA】生成AI・機械学習向けおすすめGPU

- 5.1.NVIDIA H200

- 5.2.NVIDIA GH200

- 5.3.NVIDIA H100 NVL

- 5.4.NVIDIA A100

- 5.5.NVIDIA RTX 4090

- 6.【NVIDIA以外】生成AI・機械学習向けおすすめGPU

- 6.1.Radeon Pro VII|AMD

- 6.2.Radeon RX 7900 XTX|AMD

- 6.3.Instinct MI300X|AMD

- 6.4.Data Center GPU Max 1550|Intel

- 6.5.Google TPU v5e|Google Cloud

- 7.AI向けGPU購入時に失敗しないための3つのポイント

- 8.AI用途でGPUを使用するなら「HIGHRESO」のGPUクラウド

AI開発向けのGPUとは?

AI開発向けのGPUとは、ディープラーニングや機械学習などのAI開発に最適化されたグラフィックス・プロセッシング・ユニットのことを指します。

一般的なゲーミング用途のGPUと比べて、AI開発で必要とされる「大量の行列演算」や「並列計算」を高速に処理できるように設計されているのが特徴です。

AI向けGPUの価格相場

AI向けGPUは、用途や性能によって価格帯が異なりますが、およそ100万円〜400万円ほどと言えるでしょう。

個人開発向けのエントリーモデルから、企業や研究機関向けのハイエンドモデルまで幅広く展開されており、選択肢によって初期投資やコストパフォーマンスも変わってきます。

ここでは、AI用途向けのGPUモデルをクラス別に価格の相場を比較していきます。

AI向けGPUとゲーミングGPUの違いは?

AI向けGPUとゲーミングGPUの違いは、

- AI向けGPU:精度重視・大規模演算用

- ゲーミングGPU:映像重視・リアルタイム描画用

です。

つまり、AI向けは計算性能とメモリ容量重視、ゲーミングは映像描画性能重視という違いがあります。

AI向けGPUは、数千のコアによる高い並列処理能力で、CPUよりも効率的に大量データや複雑な計算を高速に処理できます。 高精度なAIモデルの学習や推論には不可欠で、ゲーム用GPUよりも演算性能やメモリ容量、長時間運用の安定性、エンタープライズ向けサポートが強化。

そのため、AI研究や開発の現場では、より信頼性が高く専門的なGPUが選ばれやすくなっているのです。

AI用途のGPUはNVIDIAがなぜおすすめなのか

結論から言えば、NVIDIAのGPUはCUDAによる圧倒的な開発環境と主要AIフレームワークとの高い互換性により、AI用途で最も効率的かつ実用的だからです。

NVIDIAのGeForceシリーズは、AI分野でスタンダードとされている「CUDAプラットフォーム」に対応しており、AI生成やディープラーニング、機械学習の分野で圧倒的なシェアを誇っています。

CUDAは、NVIDIA GPUの性能を最大限に引き出すためのプログラミングモデルであり、AI開発に必要な膨大な並列計算を高速に処理することができるのです。

また、NVIDIA Broadcastのような独自のアプリケーションや、TensorFlow、PyTorchといった主流のAI開発フレームワークとの高い互換性があるのもおすすめの理由です。

AI開発で利用するGPUを購入する際の選び方

AI開発で利用するGPUを購入する際は、単に人気であるからではなく、以下4つの観点から選択しましょう。

- 初期コストと運用コストのバランスを比較する

- 処理するAIタスクに応じて「コア」の種類を選定する

- モデルサイズとGPUメモリ容量の整合性を確認する

- 熱処理・冷却性能の水準を明確にする

初期コストと運用コストのバランスを比較する

購入時の価格だけでなく、運用にかかる継続的な費用も合わせて比較し、トータルでコストパフォーマンスに優れたGPUを選ぶことが重要です。

例えば、オンプレミス(自社設置型)でGPUを購入する場合、最初に本体や関連機器をまとめて買うため、導入時に大きな初期投資が必要です。

しかし、一度購入してしまえば、月々の利用料などの追加費用がほとんどかからず、長期間使い続けることで、クラウドサービスをずっと借り続ける場合よりも、最終的なコストが安くなる可能性があります。

「とにかく初期費用を抑えたい」という方も多いですが、中長期的に見ると費用がかさんでいる事もあるため、注意しましょう。

処理するAIタスクに応じて「コア」の種類を選定する

AI GPUは、GPUに搭載されているコアの種類や特徴を意識して選ぶことも重要です。GPUのコアとは、並列で演算処理を行う小さな計算ユニットのこと。

コアは以下4つの観点から選択します。

- 予算と用途のバランス:専用コアは高価だが、特定用途では圧倒的な性能向上

- 将来性:AI分野の急速な発展により、TensorコアやMatrixコアの重要性が増加

- 互換性:開発環境やソフトウェアがサポートするコア種類を確認

- 電力効率:専用コアは該当処理において電力効率が優秀

また、コアは種類もさまざまで、メーカーによって特徴も異なります。「どのコアを選んだらいいかわからない」という方は、以下の表を参照ください。

コア種類 | メーカー | 主な特徴 | 用途 | 選択すべきケース |

CUDA | NVIDIA |

|

|

|

|---|---|---|---|---|

Tensor | NVIDIA |

|

|

|

RT | NVIDIA |

|

|

|

Matrix | NVIDIA |

|

|

|

FP64 | NVIDIA |

|

|

|

モデルサイズとGPUメモリ容量の整合性を確認する

GPUを購入する前に、使いたいAIモデル(ニューラルネットなど)の重さや必要なデータ量が、GPUのメモリ容量に収まるかどうか事前に確認する必要があります。

モデルやバッチサイズが大きいと、GPUのメモリを多く消費する仕組みがあるので、メモリ容量が足りないと、学習や推論が途中でエラーを起こしたり、極端に処理が遅くなってしまうことがあります。

そのため、モデルのパラメータサイズとバッチサイズを考慮し、推定される必要VRAMに対して20〜30%程度の余裕を持ったGPUを選ぶことが重要です。特に大規模モデルを扱う場合は、A100やH100のような80GB以上のVRAMを搭載したGPUやマルチGPU構成の検討も必要になるでしょう。

熱処理・冷却性能の水準を明確にする

使いたいGPUがどれくらい発熱するか、その熱をしっかり冷やせる冷却性能が備わっているかを事前に確認しておきましょう。高性能GPUは発熱量が大きいため、十分な冷却ができないと性能が落ちたり、故障の原因になることがあります。

GPUの発熱量(TDP)や推奨される冷却機構(空冷・水冷など)、PCケースのエアフローなどを確認し、自分の環境で安全に使えるかを明確にしておくことが大切です。

AI用途におけるNVIDIAとAMDを徹底比較

AI分野では、NVIDIAとAMDのGPUが大きなシェアを占めています。

両社はアーキテクチャやソフトウェア対応、価格帯や性能面でそれぞれ独自の強みを持ち、用途や開発環境によって最適な選択肢が異なります。どちらを選ぶか迷っている方は以下の表を参照ください。

項目 | NIVIDIA | AMD |

重要ポイント |

|

|

製品ラインナップ |

|

|

アーキテクチャ | Ampere / Hopper | CDNA3 / CDNA4 |

主な用途 | トレーニング&推論、高性能計算 | トレーニング&推論、高スループット推論 |

演算性能 |

|

|

ベンチマーク | MLPerfでH100が高評価、Blackwell世代で大規模LLM最大2倍高速化 | MLPerfでH100に迫る性能、ドルあたりトークン生成量で優位、MI355XがB200比1.2–1.3倍高速 |

ソフトウェアエコシステム |

|

|

コストパフォーマンス | 高価格だがDGX/SuperPODなど統合インフラとサポート含めTCOで評価 | 同性能で最大40%コスト削減、大容量VRAMを低価格で提供 |

(出典:NVIDIA HGX プラットフォーム|NVIDIA)

NVIDIAはCUDAを中心とした業界標準の開発環境や最適化ライブラリが充実しており、大規模LLMの学習や生成AI開発など最先端のAIプロジェクトに取り組む研究者や企業に適しています。

一方、AMDは大容量VRAMを搭載しつつコストパフォーマンスに優れた製品を提供しており、メモリ集約型ワークロードを低コストで処理したいスタートアップや、ベンダーロックインを避けたい開発者、オープンエコシステムを活用したいユーザーにおすすめです。

【NVIDIA】生成AI・機械学習向けおすすめGPU

ここからは生成AI・機械学習向けのNVIDIAが提供するGPUを紹介します。紹介する商品は以下のとおりです。

- NVIDIA H200

- NVIDIA GH200

- NVIDIA H100 NVL

- NVIDIA A100

- NVIDIA RTX 4090

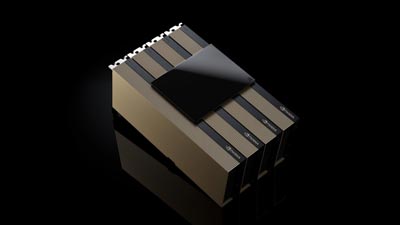

NVIDIA H200

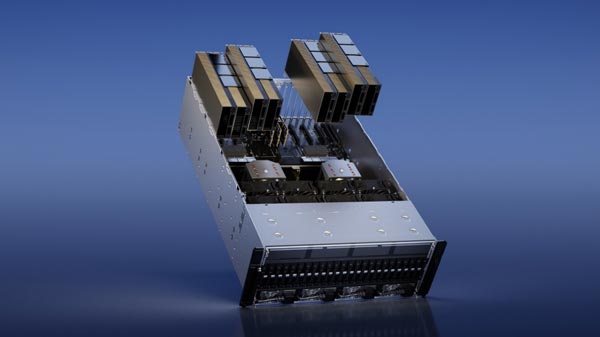

(出典:NVIDIA)

NVIDIA H200は、生成AIやハイパフォーマンスコンピューティング向けに設計された、高性能なGPUです。2023年11月13日に発表され、前モデルであるNVIDIA H100の後継として位置づけられています。

H200の大きな特徴は、世界で初めてHBM3eという高速・大容量メモリを採用した点にあります。メモリ容量はH100の約2倍となる141GB、メモリ帯域幅は1.4倍の毎秒4.8TBと大幅に性能が上がっています。

NVIDIA GH200

(出典:NVIDIA)

NVIDIA GH200(Grace Hopper)は、高性能なArm CPUとHopper GPUを統合したスーパーチップです。

同じ「Hopper」アーキテクチャをベースにしているため混同されがちですが、その製品コンセプトとアーキテクチャは根本的に異なります。

GH200は、GPU自身のメモリ(最大144GB)に加えて、CPUに接続された大容量のLPDDR5Xメモリ(最大480GB)にも、GPUが直接、高速にアクセスできます。

これを「統合メモリ空間」と呼び、GPUは合計で600GBを超える巨大なメモリプールを自由に使えるようになるのが大きな特徴です。

NVIDIA H100 NVL

(出典:NVIDIA)

NVIDIA H100 NVLは、NVIDIAの「Hopper」アーキテクチャを採用したデータセンター向けの高性能GPUの一つです。特に大規模言語モデル(LLM)など生成AIの推論や、AI推論サーバーの運用に最適化されています。

「NVL」とは「NVLink」を意味し、2枚のH100 GPUをNVLinkブリッジで直結した構成になっています。

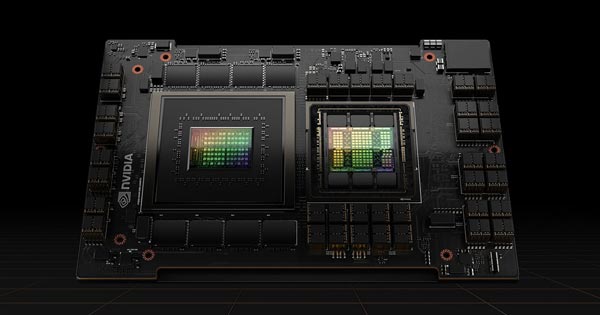

NVIDIA A100

(出典:NVIDIA)

NVIDIA A100は、NVIDIAの「Ampere(アンペア)」アーキテクチャを採用したデータセンター向けのハイエンドGPUです。

2020年に発売が開始されて、AI(ディープラーニング)の学習・推論、HPC(高性能計算)、データ分析など幅広い分野で利用されています。最新のH100/H200の前世代ですが、現在でも多くのクラウドや研究機関で主力GPUとして活躍しています。

NVIDIA RTX 4090

(出典:価格.com)

NVIDIA GeForce RTX 4090は、NVIDIAの「Ada Lovelace」アーキテクチャを採用した、2022年発売のハイエンドゲーミング&クリエイター向けGPUです。

GeForce RTX 40シリーズの最上位モデルで、プロのクリエイターやハイエンドゲーマー、また個人が所有できるGPUとしては最強クラスの性能を持っています。

【NVIDIA以外】生成AI・機械学習向けおすすめGPU

近年、生成AIや機械学習の発展に伴い、NVIDIA以外のGPUも注目を集めています。ここではおすすめのAI向けGPUを5つ紹介します。

- Radeon Pro VII|AMD

- Radeon RX 7900 XTX|AMD

- Instinct MI300X|AMD

- Data Center GPU Max 1550|Intel

- Google TPU v5e|Google Cloud

Radeon Pro VII|AMD

(出典:amazon.co.jp)

Radeon Pro VIIは、AMDが2020年に発表したワークステーション向けのGPUです。

主に科学技術計算(HPC)、プロフェッショナルな映像編集、CAD、CGレンダリング、シミュレーションなどの分野をターゲットに設計されています。

AMDの「Vega」アーキテクチャを採用し、高い演算性能と大容量メモリを特徴としています。

Radeon RX 7900 XTX|AMD

(出典:価格.com)

Radeon RX 7900 XTXは、AMDが2022年12月に発売したハイエンドゲーミング向けGPUです。AMDの最新アーキテクチャ「RDNA 3」を採用し、NVIDIA RTX 4080や4090に対抗する最上位モデルの一つです。

4Kゲーミングやクリエイティブ用途にも対応する高い性能を持っています。

Instinct MI300X|AMD

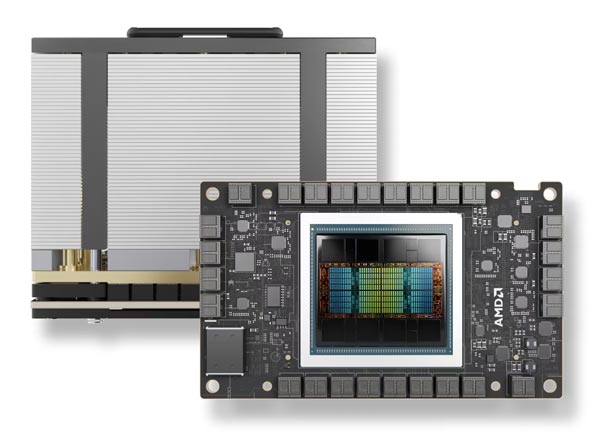

(出典:AMD)

AMD Instinct MI300Xは、AMDが2023年に発表したAIおよび高性能コンピューティング(HPC)向けのデータセンター向けGPUです。

主に生成AIの大規模モデル学習や推論、科学技術計算など、超大規模な計算負荷が求められる用途をターゲットとしています。

Data Center GPU Max 1550|Intel

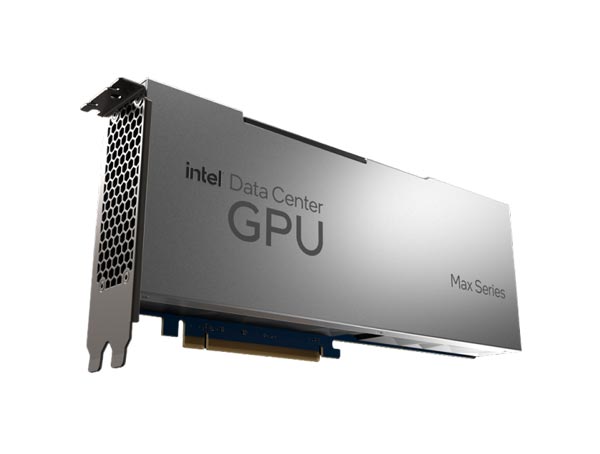

(出典:Uvation Marketplace)

Intel Data Center GPU Max 1550は、インテルが開発したデータセンター向けの高性能GPUです。

インテルのPonte Vecchioアーキテクチャを採用し、主にスーパーコンピューティングやHPC(高性能計算)、AI分野のスーパーコンピューティング、科学技術計算処理をメインに実用されています。

Google TPU v5e|Google Cloud

(出典:Google Cloud)

Google TPU v5eは、Googleが開発・提供する第5世代のTensor Processing Unit(TPU)ファミリーの一つで、クラウドベースで利用できる高性能・高効率なAI専用アクセラレータです。

トレーニングと推論の両方に強く、コスト効率やスケーラビリティにも優れているため、生成AIや大規模ディープラーニングをはじめとする幅広い機械学習ワークロードに最適です。

AI向けGPU購入時に失敗しないための3つのポイント

AI向けGPU購入時に失敗しないためのポイントを3つ紹介します。

- 用途に対して過剰な性能は選ばない

- メーカー選びは開発環境との相性を考えること

- 消費電力と冷却環境を事前に検討すること

用途に対して過剰な性能は選ばない

GPUは「用途に最適な性能」を選ぶことで、コストや運用効率を最大化できます。無駄な出費やリソースの浪費を防ぐことができ、長期運用の安定化につながります。

以下の要素を確認して、最適な選択をしましょう。

- 扱うモデルのパラメータ規模や学習・推論のバッチサイズ

- 必要な演算精度

- 利用するフレームワークとの互換性

- 将来的な拡張性

これらを踏まえて選定することで、過不足のないGPUを導入でき、投資対効果を高められます。

メーカー選びは開発環境との相性を考えること

開発環境との相性を考えずにGPUメーカーを選ぶと、「使いたいソフトウェアが動かない」「開発効率が下がる・サポートが受けられない」といったリスクがあるため、確認が必要です。

以下のポイントを整理してメーカーをしっかり選びましょう。

- フレームワークやライブラリの対応状況

- ソフトウェアの最適化・パフォーマンス

- サポートや情報の豊富さ

特にAI開発では、TensorFlowやPyTorchといった主要フレームワークがどのメーカーのGPUに最適化されているかを把握することが必須。

NVIDIA製GPUはCUDAやcuDNNによる成熟した開発環境で高い互換性と安定性を誇る一方、AMDやIntelはROCmやoneAPIといった独自環境が必要で最適化度合いも異なります。導入前に自社で利用するソフトウェアやライブラリが円滑に動作するか確認することが、開発効率や運用安定性を確保するうえで重要です。

消費電力と冷却環境を事前に検討すること

高性能GPUを導入する際は、機材が最大限のパフォーマンスを発揮し、かつ長期的に安定稼働できるよう、消費電力と冷却環境を事前に検討しましょう。近年のAI向けハイエンドGPUは消費電力が大きく、安定した電力供給が確保されないと動作不良や故障につながるリスクが高まります。

また、高負荷処理時には膨大な熱を発生するため、冷却が不十分だと熱によるクロック制限がかかり、処理速度が低下して本来のパフォーマンスを発揮できなくなる可能性も。

加えて、消費電力や発熱量が大きいGPUは家庭用電源や小型ケースでは対応できない場合があるため、ラック型や大型ワークステーション、エアフローを確保した設置環境が必要です。こうした要素を導入前に総合的に確認することで、トラブル防止や長期的な運用コストの削減につながります。

AI用途でGPUを使用するなら「HIGHRESO」のGPUクラウド

AI向けGPUを選ぶ際には、性能や価格だけでなく、

- 用途に応じた必要スペック

- 開発環境との互換性

- メモリ容量や冷却・電力要件

を総合的に考慮することが重要です。特にNVIDIAはCUDAを中心とした充実した開発環境と高い互換性で先端開発を進める企業や研究者に適しています。

また、「AI用途でGPUを使用したいがコストが高く導入ができない」という方は、HIGHRESOを利用を検討してみてはいかがでしょうか。

HIGHRESOでは、業界最安級でNVIDIAの「H200」を提供しており、以下の資料では、基本的なサービスの説明から、ユースケース、他社GPUクラウドとの比較、セキュリティ、導入実績まで記載しています。