【Llama2】Meta・HuggingFaceへの利用申請

この記事では、Llama2を使用するためのMeta・HuggingFaceへの利用申請について解説しています。

目次[非表示]

- 1.Llama2とは

- 2.Metaへのモデル利用申請

- 3.HuggingFaceの設定

- 4.生成AI・LLMならGPUクラウド

- 5.まとめ

Llama2とは

Llama2(Large Language Model Meta AI 2/ラマツー)とは、Facebookを運営するMeta社が開発した言語生成AI(LLM)で、OpenAI社のChatGPTに匹敵するの性能を持っています。

Llama2の特徴としては、軽量モデルで高性能、そして無料で使えるオープンソースであるため、開発者にとって扱いやすいモデルになっています。

Llama2のモデルを使用するにあたって、Metaへの申請やHuggingFaceでの設定が必要になります。

Llama2の詳細については、以下の記事で解説しています。

Metaへのモデル利用申請

Llama2のモデルを使用するにあたり、Metaへの申請方法を解説します。

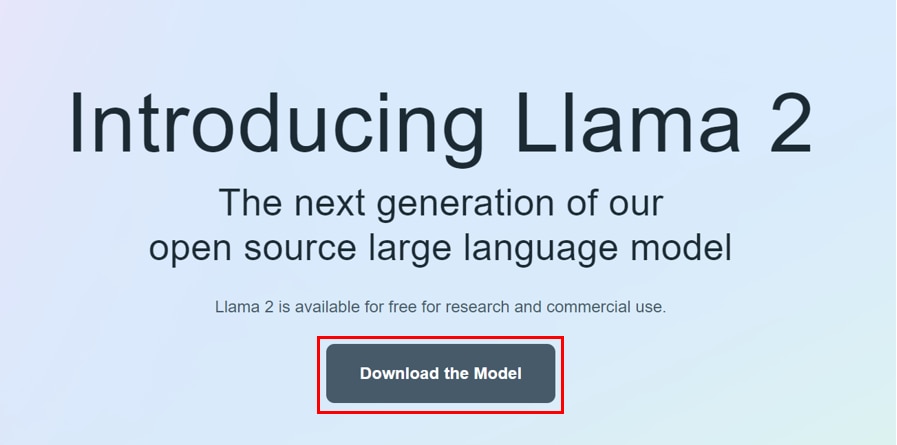

申請は以下のサイトから行います。

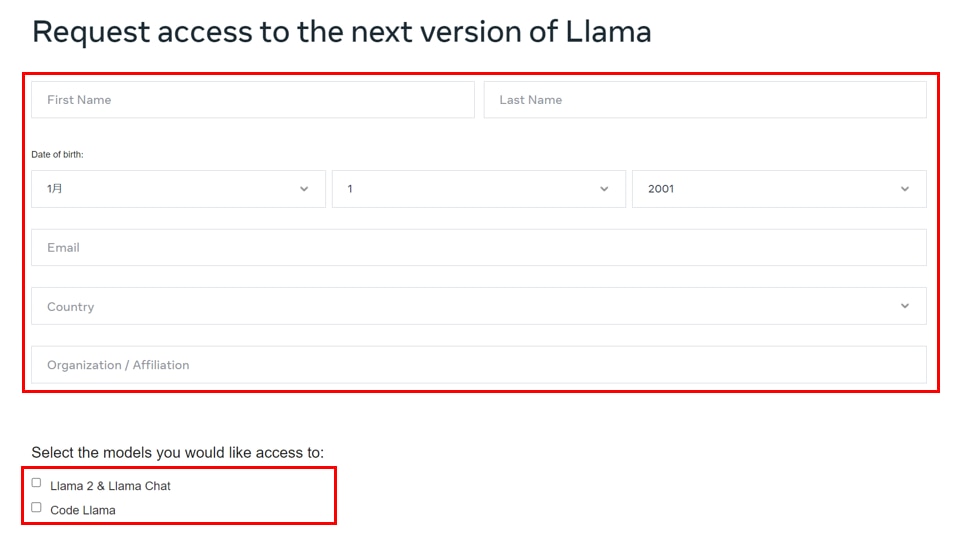

[Download the Model]をクリックすると、[Request access to the next version of Llama]の画面に遷移しますので、必要事項を入力します。

[Select the models you would like access to:]の項目で、[Llama2&Llama Chat]および[Code Lama]にチェックを入れます。

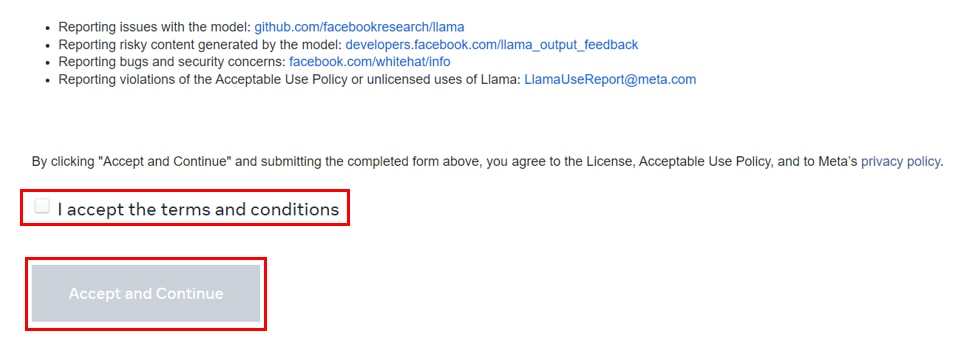

[I accept the terms and conditions]にチェックを入れて、[Accept and Continue]ボタンをクリックします。

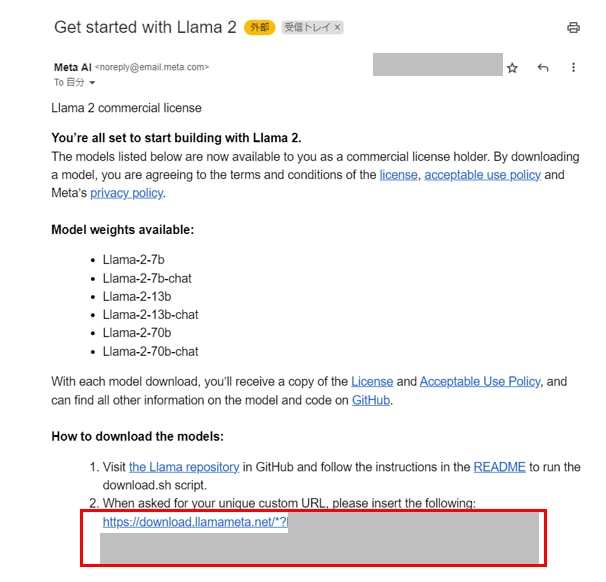

承認メールが届くのに数日かかる可能性があります。タイミングによっては早く承認されるかもしれません。

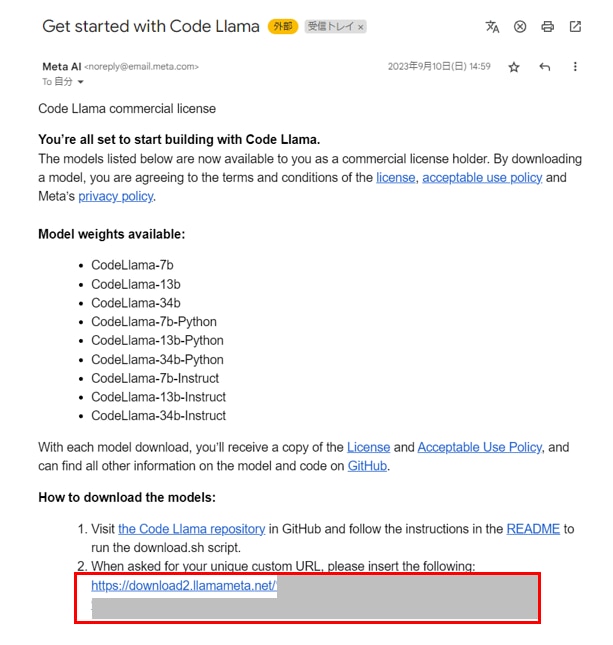

メールに書かれているリンク[https://download.llamameta.net/~Download-Request-ID=xxxxxx]は後に使うため、控えておきます。

Llama2の承認メール

Code Llamaの承認メール

HuggingFaceの設定

HuggingFaceを使ってLlama2を使用する場合の設定方法について解説します。

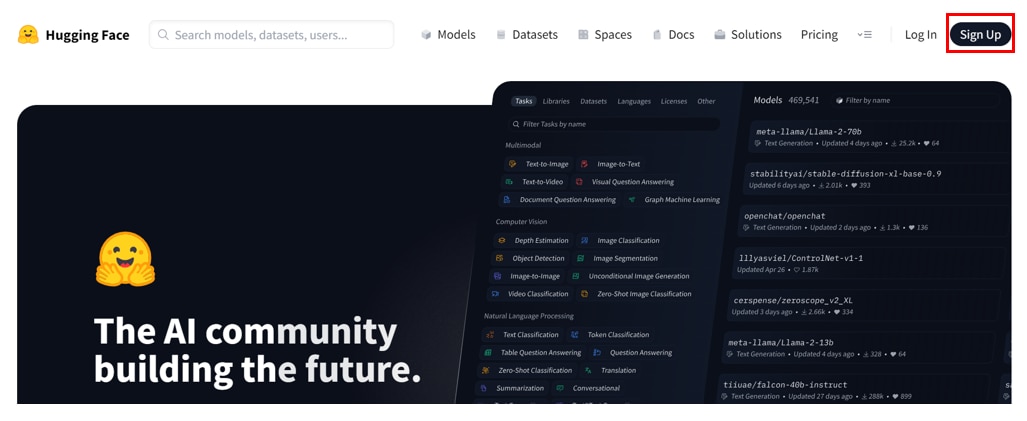

HuggingFaceのアカウント作成

HuggingFaceのアカウント未作成の場合は、[Sign Up]からアカウントを作成してください。

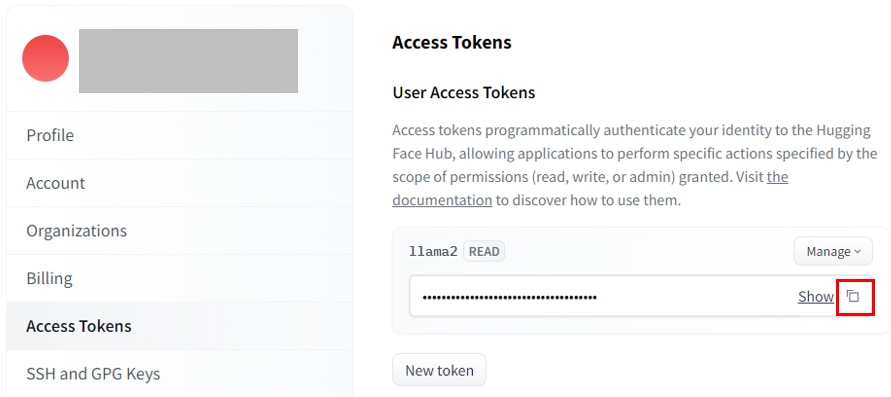

HuggingFaceでトークン作成

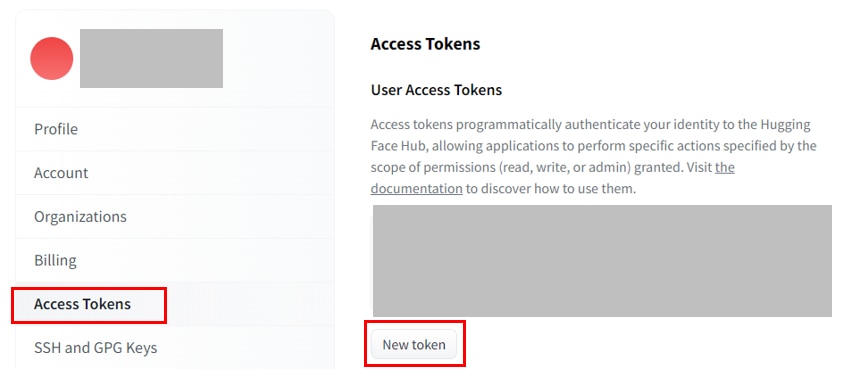

HuggingFaceに接続してモデルをダウンロードするのにアクセストークンの作成が必要になります。

HuggingFaceログイン後、ヘッダーの[赤い丸印]から[Settings]を選択します。

サイドバーから[Access Tokens]を選び、[New token]ボタンをクリックします。

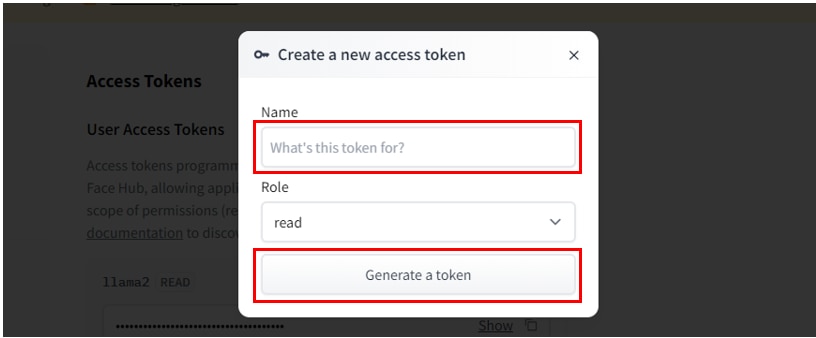

[Create a new access token]のページで、[Name]にアクセストークンの任意の名称を入力し、[Generate a token]をクリックするとアクセストークンが作成されます。

アクセストークンは後ほど使用するため、控えておきます。

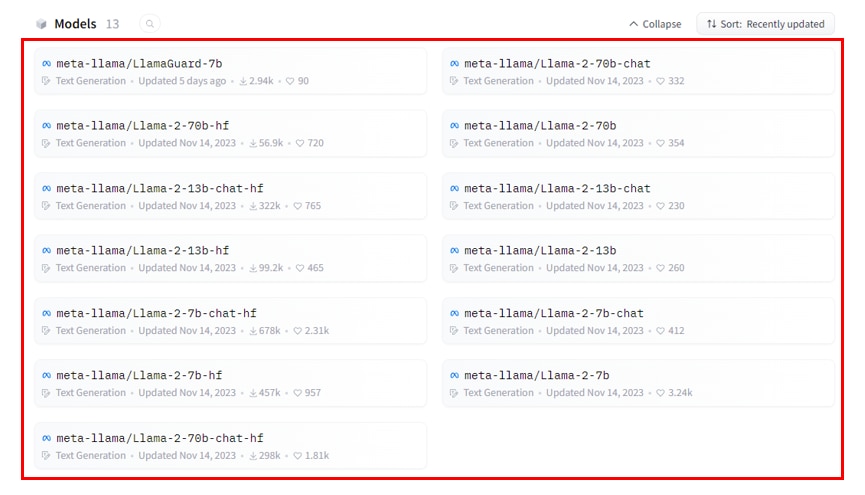

HuggingFaceでモデルの利用申請

Huggingfaceの以下のページにアクセスし、モデルの利用申請をします。

[Models]から利用するLlamaのモデルを選択します。

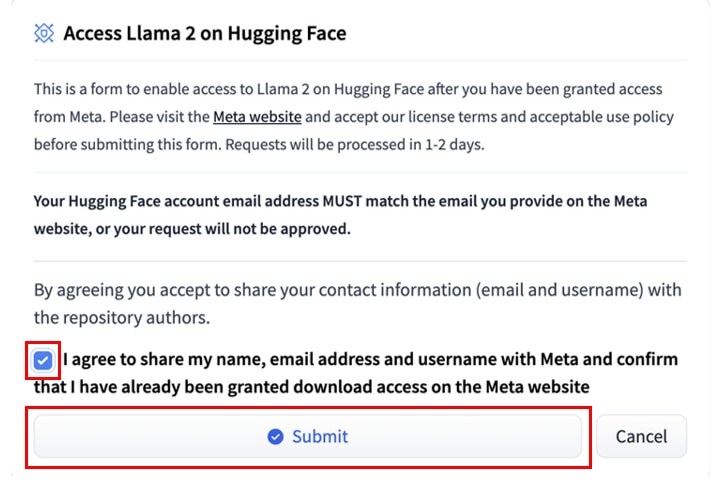

遷移したページで[I agree~Meta website]にチェックをいれて、[Submit]をクリックします。

このときモデル使用申請時にMetaに登録したメールアドレスと、HuggignFaceで登録したメールアドレスが同じである必要がありますので、ご注意ください。

Submitボタンをクリック後に以下の表示がされ、リポジトリ管理者からのレビュー待ちになりますので、しばらく待ちます。

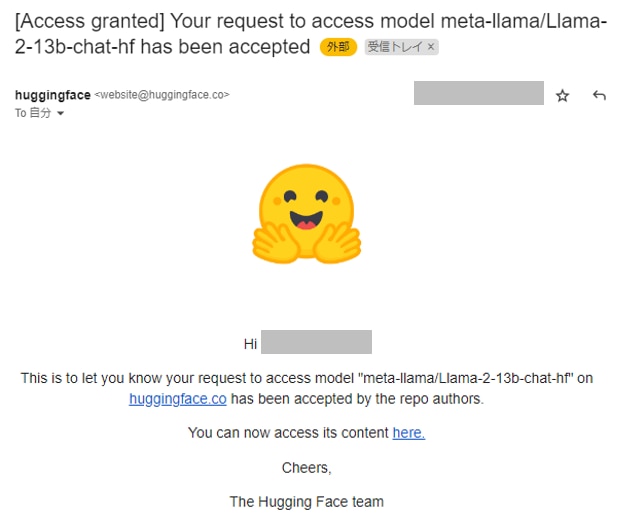

[Access granted] Your request to access model meta-llama/xxxxx has been acceptedというタイトルで、HuggingFaceからメールが届くと承認完了です。

ここまでがMeta・HuggingFaceへの利用申請になります。

モデルの使い方については、以下の記事で解説しています。

生成AI・LLMならGPUクラウド

Llama2やその他のLLMを使用する際には、モデルサイズやタスクに応じて必要なスペックが異なります。

LLMで使用されるGPUは高価なため、買い切りのオンプレミスよりも、コストパフォーマンスが高く柔軟な使い方ができるGPUクラウドをおすすめしています。

GPUクラウドのメリットは以下の通りです。

- 必要なときだけ利用して、コストを最小限に抑えられる

- タスクに応じてGPUサーバーを変更できる

- 需要に応じてGPUサーバーを増減できる

- 簡単に環境構築ができ、すぐに開発をスタートできる

- 新しいGPUを利用できるため、陳腐化による買い替えが不要

- GPUサーバーの高電力・熱管理が不要

コスパをお求めなら、メガクラウドと比較して50%以上安いGPUクラウドサービス「GPUSOROBAN」がおすすめです。

大規模なLLMを計算する場合は、NVIDIA H100のクラスタが使える「GPUSOROBAN AIスパコンクラウド」がおすすめです。

まとめ

この記事では、Llama2を使用するためのMeta・HuggingFaceへの利用申請について紹介しました。

Llama2は無料で使えて商用利用可能な利便性の高いモデルでありながら、ChatGPTと同等以上の性能があります。

Llama2に関する詳細な情報は、以下の記事でまとめて紹介していますので、あわせてご覧ください。